ICTP-SAIFR realiza Escola em Lima sobre Física de Altas Energias e Cosmologia

Evento externo buscou estimular pesquisa básica no Peru e fornecer a estudantes de todo o país um panorama sobre as áreas de Física de Partículas e de Neutrinos

Na última semana, a Universidad Nacional de Ingeniería (UNI), em Lima, Peru, sediou a “Primeira Escola Peruana em Física de Altas Energias e Cosmologia”. A Escola, proposta pela UNI, foi o primeiro evento externo do ICTP-SAIFR em 2015. Entre seus objetivos estavam estimular a pesquisa básica no Peru e inspirar estudantes de física do país a continuarem na área. Palestrantes convidados incluíram Maria Concepción González-García, da Universidade Stony Brook, e Sonia Pabán, da Universidade do Texas.

Durante o evento de uma semana – que começou dia 22 de Junho e terminou dia 26 – temas relacionados à Física de Partículas, Cosmologia e Física de Neutrinos foram apresentados para alunos de todo o país, desde estudantes de graduação até doutorandos. A ideia da Escola era fornecer a eles uma visão geral dessas áreas e também discutir alguns dos mais recentes trabalhos desses campos. Além das palestras teóricas, os alunos também elaboraram projetos em grupo com a supervisão dos professores, para que pudessem desenvolver de maneira mais aprofundada as ideias apresentadas em aula.

Física de Partículas – Modelo Padrão e Bóson de Higgs

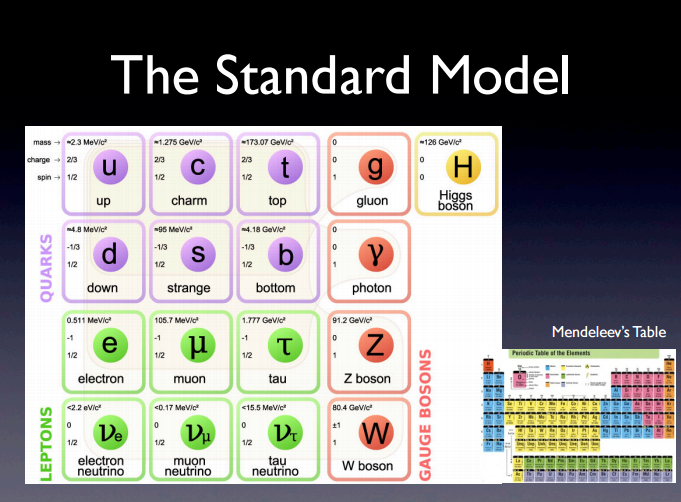

As aulas sobre Física de Partículas foram ministradas pelo pesquisador do ICTP-SAIFR Eduardo Pontón. Ao longo de seu curso, Pontón falou sobre a formulação do Modelo Padrão e sobre a atual situação da área de Física de Partículas após a descoberta do Bóson de Higgs.

“Minha intenção era falar sobre os conceitos mais básicos a respeito do Modelo Padrão e sobre o processo de descoberta do Bóson de Higgs e suas consequências”, disse Pontón. “Gostaria que entendessem porque foi tão difícil e demorou tanto tempo para descobrirmos essa partícula; abordei, por exemplo, as probabilidades de decaimento do Bóson e outras características”.

Com a descoberta do Bóson de Higgs em 2012 pelo Large Hadron Collider (LHC), o Modelo Padrão ficou completo – todas as partículas previstas haviam sido identificadas. Encontrar novas partículas, um dos objetivos da segunda fase de coleta de dados do LHC iniciada recentemente, significaria a existência de uma Física além do Modelo Padrão.

“Há evidências no universo de que existe uma nova Física”, diz Pontón. “No Modelo Padrão, não há nenhuma partícula candidata para explicar a matéria escura, por exemplo. Além disso, não temos explicação para o fato de que existe uma quantidade muito maior de matéria do que de anti-matéria no nosso universo, fato conhecido como Assimetria Bárion/Antibárion”.

Neutrinos e Cosmologia

Neutrinos também foram um tema abordado durante a Escola. Essas partículas interagem de maneira extremamente fraca com a matéria e, portanto, são muito difíceis de detectar. O estudo de neutrinos e de suas oscilações – um neutrino pode se transformar em outro tipo de neutrino ao longo de sua trajetória pelo espaço – podem fornecer informações, por exemplo, sobre a origem dos diferentes tipos ou sobre novas fontes de violação da simetria CP (Carga e Paridade) que poderiam ter um papel na Assimetria Bárion/Antibárion. Pesquisas com neutrinos poderiam ajudar até mesmo a entender como galáxias são formadas.

Já entre os temas de Cosmologia se destacaram a história do universo, especialmente a Inflação – período do início do universo durante o qual o espaço se expandiu rapidamente. A Radiação Cósmica de Fundo, tipo de radiação mais antiga do universo, também foi discutida: seu estudo pode revelar aspectos sobre o início do universo.

Continue Reading | Comments Off on ICTP-SAIFR realiza Escola em Lima sobre Física de Altas Energias e Cosmologia

Um pouco de história: Abdus Salam e a criação do ICTP

Um instituto de pesquisa que promove a ciência básica em países em desenvolvimento. Hoje o ICTP, assim como o ICTP-SAIFR, tem essa como uma de suas principais características. Porém, há pouco mais de 50 anos atrás, esse era apenas um sonho do físico paquistanês Abdus Salam.

“A noção de um Centro que atenda particularmente às necessidades dos físicos de países em desenvolvimento viveu comigo desde 1954, quando fui forçado a deixar o meu próprio país porque percebi que se ficasse muito mais tempo por lá eu teria de deixar a Física, devido puramente ao isolamento intelectual”, disse ele uma vez. (Ideals and Realities 3rd ed., World Scientific, 392, 1989).

Primeira visita de Abdus Salam à Trieste, em 1960, para um simpósio sobre interação de partículas elementares

A história do ICTP começou em 1960. Nesse ano, Salam se tornou professor de Física Teórica no Imperial College onde, junto com Paul Matthews, criou um grupo de pesquisa nessa área. Ainda em 1960, Salam, como representante do Paquistão, propôs ao IAEA (International Atomic Energy Agency) a criação de um centro internacional de Física Teórica.

A proposta de Salam foi discutida e se tornou uma realidade quatro anos depois. Em 1964, o ICTP foi fundado em Trieste, na Itália, e Salam se tornou seu diretor. Devido à Guerra Fria, a Europa vivia naquela época uma grande separação entre países do leste e do oeste do continente. Portanto, desde a sua criação, o ICTP se tornou uma rara ponte de comunicação entre diferentes países.

Primeiro Conselho Científico do ICTP, em 1964, presidido por Robert Oppenheimer

Ao longo dos 50 anos seguintes, o ICTP manteve o ideal de seu principal criador. O Centro continuou a reunir cientistas do mundo inteiro e a promover a ciência básica principalmente em países em desenvolvimento. Com o suporte financeiro do governo italiano, da IAEA e de agências como a UNESCO, o instituto já ajudou mais de 140 mil cientistas a participarem de conferências, workshops, cursos e outros eventos.

Em 2010, o ICTP, em colaboração com a Universidade Estadual Paulista “Júlio de Mesquita Filho” (Unesp) e com a Fundação de Amparo à Pesquisa do Estado de São Paulo (FAPESP) criou um novo centro, localizado na América do Sul – o ICTP-SAIFR. O objetivo continua o mesmo: promover a pesquisa básica no mais alto nível internacional, mas dessa vez com enfoque especial nos países sul-americanos.

Abdus Salam foi laureado com o prêmio Nobel em 1979, junto com Steven Weinberg e Sheldon Glashow, por suas contribuições à teoria de unificação entre as interações fraca e eletromagnética entre partículas elementares, incluindo a previsão da corrente neutra fraca

Continue Reading | Comments Off on Um pouco de história: Abdus Salam e a criação do ICTP

Estudando interações na Teoria das Cordas

Trabalho que se originou durante parceria do ICTP-SAIFR com o Perimeter Institute propõe nova forma de olhar para os fenômenos de interação entre cordas

Entre os meses de novembro de 2014 e fevereiro de 2015, o ICTP-SAIFR realizou uma parceria com o Perimeter Institute, do Canadá, para estudar temas relacionados a Teoria de Campos. Durante esse período, a colaboração promoveu o intercâmbio de pesquisadores e alunos entre os institutos. Três meses após o final da parceria, Benjamin Basso, Shota Komatsu e Pedro Vieira, publicaram um artigo baseado em ideias que surgiram ao longo de sua estada no ICTP-SAIFR.

“Tivemos as ideias e começamos a discuti-las enquanto estávamos no Brasil”, diz Basso. “Nós vimos, de imediato, potencial nessas ideias, então as desenvolvemos e testamos suas previsões”.

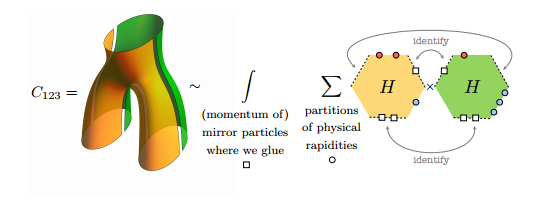

O trabalho dos pesquisadores está relacionado à Teoria das Cordas – mais especificamente em sua dualidade com acoplamentos fortes na Teoria Quântica de Campos. De acordo com a teoria, as cordas são elementos fundamentais e suas vibrações estão relacionadas com a energia e massa das partículas que formam. O estudo de Basso e seus colegas fornece uma nova maneira de olhar para o modo como as cordas interagem entre si, e para o que acontece quando uma dessas cordas se quebra em duas ou quando duas cordas se unem.

“Muitas vezes em Física, para tentar resolver um grande problema, tentamos quebrá-lo em problemas menores e mais simples”, explica Basso. “Foi isso que fizemos nesse trabalho. Em vez de estudar um problema complexo, que envolve um objeto no formato de um par de calças, cortamos esse objeto em dois hexágonos. Com essas formas geométricas mais elementares, tornamos o problema mais simples tanto conceitualmente como tecnicamente; nós conseguimos resolver, explicitamente, os problemas relacionados aos hexágonos usando a integrabilidade da teoria”.

Leia o artigo clicando aqui.

O próximo passo do trabalho será verificar se o modelo se mantém válido após os hexágonos serem “colados” novamente, recriando a estrutura original no formato do par de calças.

“Sabemos que nossa descrição funciona quando as duas metades estão separadas, mas ainda não podemos afirmar que ela continuará válida após a união das metades em uma só forma”, diz Basso. “Estamos otimistas e vamos continuar polindo essas figuras para fazer a verificação. Caso o modelo se mostre correto, conseguiremos entender melhor as interações entre os elementos fundamentais da Teoria das Cordas”.

Continue Reading | Comments Off on Estudando interações na Teoria das Cordas

LHC observa decaimentos raros com alta precisão pela primeira vez

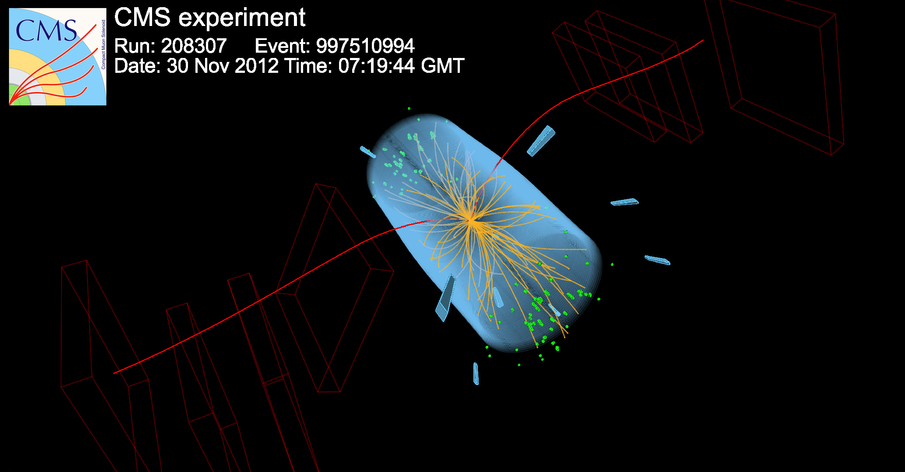

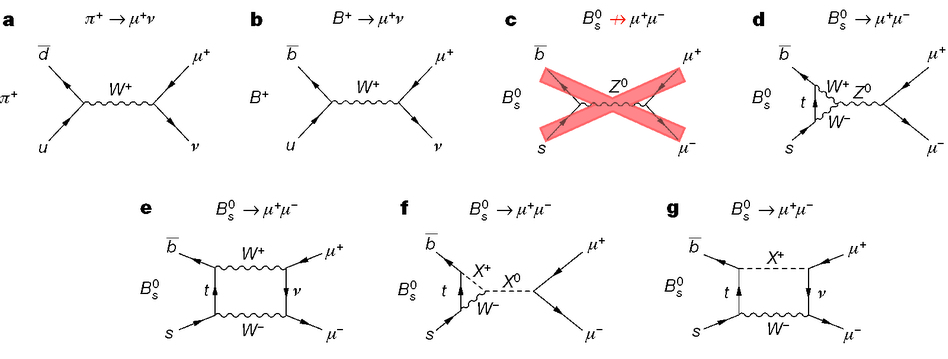

Cientistas do Large Hadron Collider (LHC) anunciaram nesse mês de maio a observação, com altíssima precisão, de um fenômeno extremamente raro: o decaimento de mésons B0s e B0 em dois múons. Esses mésons podem decair de várias maneiras diferentes, e as probabilidades desses decaimentos específicos são de cerca de 1 para cada 250 milhões de mésons B0s produzidos e de 1 para cada 10 bilhões de mésons B0. A análise dos dados foi feita por pesquisadores do CMS (Compact Muon Solenoid) e LHCb (Large Hadron Collider beauty), e teve a participação do Centro de Pesquisa e Análise de São Paulo (SPRACE), que faz parte da colaboração CMS.

Leia o artigo, publicado na revista científica Nature, clicando aqui.

“Foi a primeira vez que conseguimos observar o decaimento de Bs com uma significância estatística maior do que 6 sigmas, o que equivale a uma probabilidade de apenas uma parte em um bilhão do resultado não ser real”, explica Sérgio Novaes, coordenador do SPRACE. “A observação está de acordo com as previsões do Modelo Padrão e é importante porque pode ajudar a descartar ou restringir modelos de Física além do Modelo Padrão que preveem taxas de decaimento diferentes”.

As observações foram feitas entre 2011 e 2012, durante a primeira fase de experimentos do LHC. Esse ano o acelerador foi ligado novamente para uma segunda etapa e começará a coleta de dados nos próximos meses, dessa vez com uma energia de 13 TeV – um aumento de 5 TeV em relação à energia máxima da primeira fase.

“Com energias e luminosidades maiores, poderemos fazer medidas ainda mais precisas”, diz Novaes. “O LHC irá procurar por novas partículas e poderá testar até onde o Modelo Padrão se mantém válido”.

Diagramas relacionados ao decaimento dos mésons analisados; o item c) não é permitido pelo Modelo Padrão

Além do Modelo Padrão

“O Modelo Padrão não consegue explicar tudo”, diz Eduardo Pontón, pesquisador do ICTP-SAIFR. “Não sabemos, por exemplo, do que a matéria escura é feita e por que há um grande desequilíbrio na proporção entre matéria e anti-matéria na constituição do nosso universo. Observações do LHC, como essa, ajudam a estabelecer novas fronteiras para o Modelo Padrão e novos limites para teorias que vão além dele e tentam explicar esses fenômenos”.

Um dos alvos de pesquisa de Pontón são os modelos de Higgs Composto. De acordo com essas teorias, o Bóson de Higgs não é uma partícula elementar, ou seja, é composto por outras subpartículas. “Até hoje essa é a única partícula elementar observada na natureza que possui spin 0, o que faz com que a teoria funcione apenas em parâmetros muito específicos”, diz ele. “O Modelo do Higgs Composto ajuda a esclarecer essa questão, entre outras”.

Além do estudo aprofundado sobre as propriedades do Bóson de Higgs, também estão entre os objetivos desta segunda fase de experimentos do LHC a busca por novas partículas e por observações que fujam às previsões do Modelo Padrão. O SPRACE não apenas continuará a atuar na análise e armazenamento de dados como buscará aumentar seu papel na colaboração CMS.

“Estamos iniciando um projeto de instrumentação, para o aprimoramento de detectores utilizados pelo CMS”, diz Novaes. “No passado, não conseguíamos observar certos fenômenos porque não tínhamos equipamentos suficientemente potentes. Agora nós temos o LHC funcionando com energias que nos permite estudar fenômenos em escalas cada vez maiores. Temos pela frente o fantástico desafio de explorar o desconhecido”.

Continue Reading | Comments Off on LHC observa decaimentos raros com alta precisão pela primeira vez

ICTP-SAIFR homenageia Isaias Raw

Instituto inaugurou uma cadeira dedicada ao cientista que criou os primeiros kits de ciência do Brasil e transformou o Instituto Butantan no maior produtor de vacinas do país

Isaias Raw não é físico. Entretanto, foi homenageado com o nome de uma Cadeira no ICTP-SAIFR na última sexta-feira. O evento refletiu um dos aspectos mais marcantes da brilhante carreira de Raw: em suas próprias palavras, “eu gosto de me meter em tudo que não me diz respeito”.

A nova Cadeira é fruto de uma doação privada de Gilberto Mautner, sobrinho de Isaias Raw, que quis homenagear o tio. A doação financiará parcialmente um novo professor para o ICTP-SAIFR, que ocupará a Cadeira Isaias Raw.

A principal semelhança entre Raw e o ICTP-SAIFR talvez seja a iniciativa de criar no Brasil centros de pesquisa com padrão de excelência mundial. Entre as muitas iniciativas de Raw destacam-se a criação dos primeiros kits de ciência do Brasil, quando dirigiu a Fundação Brasileira para o Desenvolvimento do Ensino de Ciências (Funbec). Raw também fundou a Editora da Universidade de São Paulo e a da Universidade de Brasília, criou a Fundação Carlos Chagas e o Curso Experimental de Medicina da FMUSP e, junto com o professor Walter Leser, unificou os exames vestibulares de São Paulo.

Além disso, foi diretor do Instituto Butantan e um dos principais responsáveis por torná-lo no primeiro centro produtor de vacinas no país. Sua carreira foi reconhecida com o prêmio de Comendador da Ordem Nacional do Mérito, em1995, com a Grã-Cruz da Ordem Nacional do Mérito Científico, em 2001, e com o prêmio Conrado Wessel de Ciência e Cultura em 2005.

Veja a palestra do prof. Isaias Raw

Tudo isso apesar de ter sido preso e ter seus direitos cassados na época do regime militar. “Achavam que eu era um espião comunista”, brincou ele. “Naquela época, era muito fácil eliminar alguém que competia com você. Bastava acusá-lo de ser comunista. Foi o que fizeram comigo”.

Com muito humor e honestidade, Raw falou ao longo do evento sobre sua vida e carreira, e discutiu sobre a atual situação de nossas universidades…

“Há uma desconexão entre a universidade e a sociedade. Um dos motivos pelos quais o Brasil não evolui é porque as universidades muitas vezes confundem inovação com publicação de artigos”.

sobre educação…

“Se um experimento não tem chances de dar errado, não há motivo para realizá-lo. Só quando ele dá errado é que o aluno tenta entender por que deu errado e aprende algo novo. O importante não é o experimento em si, o importante é que o aluno tire suas próprias conclusões e aprenda”.

e sobre aspectos político-econômicos do Brasil…

“Estamos em um país grande que atrai interesse internacional. Porém, estamos vendendo tudo o que vale a pena. Falta competência administrativa”.

Por essas e outras reflexões a palestra de Isaias Raw merece ser vista, por alunos e professores, cientistas e não cientistas. Raw pode não ser um físico teórico, mas a homenagem do ICTP-SAIFR não poderia ser mais merecida.

Continue Reading | Comments Off on ICTP-SAIFR homenageia Isaias Raw

ICTP-SAIFR realiza evento sobre Computação Científica

Workshop e curso abordaram o desenvolvimento de softwares voltados para pesquisas científicas de diversas áreas

O ICTP-SAIFR realizou, entre os dias 13 e 30 de abril, um evento externo do ICTP-Trieste dedicado a técnicas avançadas em computação científica. Durante esse período, foi realizado um workshop de duas semanas, voltado para pesquisadores de diferentes áreas, e um curso de uma semana, dedicado à Física de Partículas. O evento foi organizado juntamente com o Núcleo de Computação Científica (NCC) da Unesp, e contou com a presença de palestrantes internacionais, como Ivan Girotto, do ICTP-Trieste.

“Entre os nossos principais objetivos estava melhorar a compreensão sobre o desenvolvimento de softwares para ciência”, diz Girotto. “Queremos disseminar o conhecimento que temos principalmente para jovens pesquisadores, pois a computação científica tem se tornado cada vez mais importante e é aplicada atualmente a diversas áreas da ciência”.

Workshop

O Workshop teve como alvo cientistas de diferentes áreas que utilizam técnicas de computação científica em suas pesquisas. Entre os principais exemplos de aplicação estão o desenvolvimento de modelos de previsão climática e modelos em biofísica e física de partículas. O evento contou com palestras e aulas práticas, no qual os participantes desenvolveram projetos para aplicar o conhecimento adquirido ao longo do curso.

“Ao longo das duas primeiras semanas, tentamos passar para os participantes conceitos fundamentais de programação científica utilizando, entre outras ferramentas, a linguagem de programação Python”, explica Gabriel von Winckler, um dos organizadores do evento, do NCC. “Nosso objetivo era fazer com que eles conseguissem construir aplicações científicas usando essa linguagem”.

Além disso, o Workshop também estimula a colaboração entre pesquisadores de diferentes universidades e países. O evento já teve duas edições realizadas no ICTP-Trieste e se mostrou frutífero para encorajar novas parcerias e ideias.

“Vemos que os participantes continuam conversando e trabalhando em projetos juntos após a realização dos eventos”, diz Girotto. “A primeira edição do Workshop levou à criação de um evento independente relacionado a estruturas eletrônicas, por exemplo”.

Física de Partículas

O curso que seguiu as duas semanas de Workshop foi dedicado à aplicação da computação científica em Física de Partículas. Nessa área, a computação de alta performance é fundamental para realizar simulações complexas de colisão de partículas feitas em grandes aceleradores, e também para o processamento de toda a informação gerada pelos experimentos. Parte do processamento dos dados do LHC, maior acelerador do mundo que foi recentemente reativado, é realizado no SPRACE, uma estrutura de computação localizada no NCC.

Continue Reading | Comments Off on ICTP-SAIFR realiza evento sobre Computação Científica

LHC volta a ser ligado após dois anos

Maior acelerador de partículas do mundo foi ligado em abril e pretende começar nova etapa de coleta de dados em junho

Operadores do LHC confirmam a primeira circulação de feixes de prótons pelo acelerador após dois anos (Imagem: Maximilien Brice/CERN)

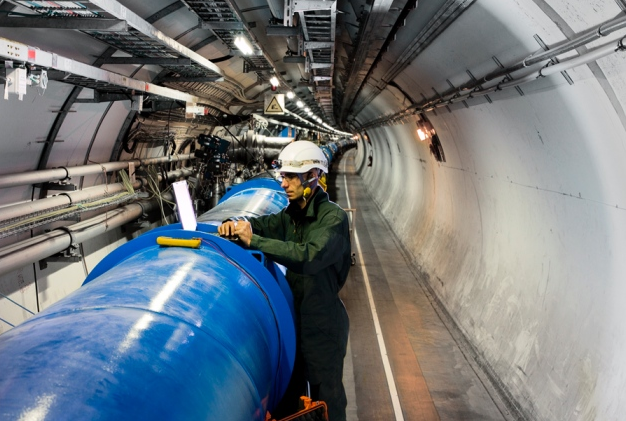

O Large Hadron Collider (LHC), maior acelerador de partículas do mundo, voltou a ser ligado nesse mês de abril após um período de dois anos de manutenção e aprimoramentos. Apesar de ainda não estar pronto para realizar colisões, no último dia 5 dois feixes de prótons circularam pelo equipamento com uma energia relativamente baixa. A previsão é que a coleta de dados comece no mês de junho, com uma energia de 13 TeV – o que superaria o recorde de 8 TeV estabelecido pelo próprio LHC.

Entre os principais objetivos dos pesquisadores para essa segunda etapa está aprofundar os estudos sobre o Bóson de Higgs e descobrir novas partículas que não pertençam ao Modelo Padrão.

Bóson de Higgs

Na primeira fase de experimentos do acelerador, o Bóson de Higgs foi descoberto – era a última partícula do Modelo Padrão que ainda não havia sido detectada. Sua massa foi calculada com uma boa precisão: 125 GeV, com um erro de 0,21 para mais ou para menos. Entretanto, ainda há muito para se descobrir sobre essa partícula.

“O LHC tentará fazer medidas mais precisas das propriedades do Bóson de Higgs e de como ele interage com outras partículas”, diz Gero von Gersdorff, pós-doutorando do ICTP-SAIFR. “A maneira como ele decai, por exemplo, pode trazer mais informações. Além disso, um grande problema em Física de Partículas é explicar por que a massa do Bóson de Higgs é tão pequena. Muitos físicos acreditam que a explicação para isso está em uma das teorias que tentam complementar o Modelo Padrão”.

Além do Modelo Padrão

Com o Modelo Padrão completo, qualquer nova partícula descoberta exigirá uma extensão do modelo. Entre as teorias mais estudadas atualmente que propõem essa extensão estão a Supersimetria e a Teoria do Higgs Composto. Na Supersimetria, todas as partículas do Modelo Padrão possuem uma partícula com massa e carga elétrica equivalentes, porém com spin diferente. Na Teoria do Higgs Composto, o Bóson de Higgs não é uma partícula fundamental, ou seja, ele é composto por outras subpartículas. Com energias mais altas, o LHC poderá detectar partículas com massas maiores e fornecer as primeiras evidências experimentais para uma dessas teorias.

“As partículas supersimétricas teoricamente mais fáceis de serem detectadas são os squarks e os gluínos, pares supersimétricos dos quarks e glúons, respectivamente”, diz Alberto Tonero, pós-doutorando do ICTP-SAIFR. “Na verdade, a detecção dessas partículas já era esperada na primeira etapa de experimentos do LHC. No modelo atual, então, a supersimetria não seria exata, pois as partículas que procuramos teriam uma massa maior. Caso elas sejam detectadas agora e sua natureza supersimétrica seja confirmada, apesar de não comprovar a teoria da Supersimetria, será um forte indício de que ela está correta”.

A segunda fase de experimentos do LHC será realizada até 2018, quando o acelerador será desligado novamente. Uma terceira fase já está confirmada, e deverá começar em 2020 ou 2021.

Continue Reading | Comments Off on LHC volta a ser ligado após dois anos

Entrevista: Roberto Kraenkel

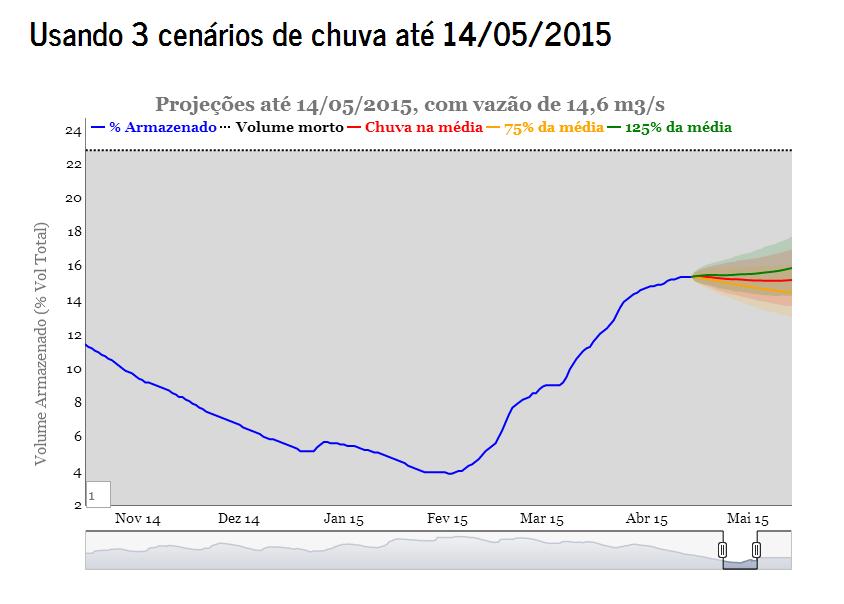

Pesquisador do IFT é um dos criadores do site Águas Futuras, que faz previsões sobre os níveis de água do sistema Cantareira

Roberto Kraenkel é físico e pesquisador no Instituto de Física Teórica da Unesp. Com o colega Paulo Inácio Prado, biólogo da USP, e o pós-doutorando Renato Mendes Coutinho, criou o site Águas Futuras, que faz previsões sobre os níveis de água do Sistema Cantareira. A página da Internet foi colocada no ar dia 14 de abril, e é muito mais do que um modelo matemático para saber se o volume do Cantareira irá aumentar ou diminuir nos próximos dias; é, também, uma tentativa de tornar mais qualificada a discussão sobre um gravíssimo problema que afeta a maior cidade do país, e de mostrar como a ciência pode contribuir para resolvê-lo, evitar novas crises e melhorar a gestão de recursos hídricos do estado e do país.

Conheça o site Águas Futuras: http://cantareira.github.io/

Ricardo Aguiar – Prof. Kraenkel, como surgiu a ideia de fazer esse projeto?

Roberto Kraenkel – Ao longo do ano passado, acompanhamos a grave crise de água que afetou, e ainda está afetando, a cidade e o estado de São Paulo. Percebemos que as discussões a respeito desse assunto eram extremamente desqualificadas. Queríamos entender melhor esse problema e tentar contribuir para tornar essa discussão pública mais qualificada.

Como trabalhamos com modelos matemáticos, buscamos entender a dinâmica de um reservatório de água – por exemplo, a taxa de absorção de água depende do volume do sistema naquele momento? Quais são os fatores mais importantes para prever e evitar crises como essa?

RA – Como funciona o modelo que criaram?

RK – Para construir o modelo usamos dados do Sistema Cantareira. O volume de água do sistema depende da quantidade de água que entra – a vazão afluente – e da quantidade de água que sai – a vazão efluente.

A quantidade que entra depende das chuvas, mas depende também do volume do sistema. Quando cheio, o sistema absorve mais água – a chuva cai diretamente na água do reservatório. Quando vazio, o sistema absorve menos água – a chuva cai também sobre o solo, que a absorve.

A quantidade que sai depende de quanta água a Sabesp retira por dia. Essa quantidade antes da crise era, em média, de 33m3/s. Com a crise, passou para 14m3/s. Embora não se fale em racionamento, fica claro que a Sabesp está enviando menos água para abastecer a cidade.

Para fazer as projeções, nos baseamos nas taxas de chuva de anos anteriores. Fizemos projeções baseadas em três cenários: com as chuvas desse ano se mantendo na média dos anos anteriores; com as chuvas desse ano ficando abaixo da média; e com as chuvas desse ano ficando acima da média. Desse modo, contemplamos desde o cenário mais pessimista até o cenário mais otimista.

RA – Como está a atual situação do Sistema Cantareira e quais as previsões mais otimistas e pessimistas?

RK – O Sistema Cantareira ainda não conseguiu recuperar o volume morto utilizado na crise.

O volume morto representa cerca de 22,6% do volume total do sistema. Atualmente, o Cantareira está com pouco mais de 15% de seu volume. Isso significa que precisamos subir mais 7 pontos percentuais para recuperarmos o volume morto.

Para manter nossas projeções precisas, fazemos previsões para no máximo 30 dias. No momento, a previsão mais otimista para daqui um mês é que o Sistema Cantareira esteja com 17,6% de sua capacidade. O mais pessimista é que esteja com apenas 12,9%.

Todas as outras projeções podem ser encontradas em nosso site.

RA – Como foi acessar os dados da Sabesp?

RK – Tivemos muita dificuldade para acessar os dados da Sabesp. Todas as informações estão disponíveis em uma página da Internet, porém não há links para essa página. Conseguimos achá-la através de contatos que temos, e se não fosse por isso não teríamos conseguido fazer o modelo.

Gostaríamos de usar esse modelo para fazer projeções para outros reservatórios também, mas é justamente pela dificuldade de acessar informações que ainda não conseguimos. Em outros estados, simplesmente não há dados disponíveis.

RA – Quais os próximos passos do projeto?

RK – Gostaríamos de elaborar um modelo que pudesse prever crises com antecipação.

O Cantareira tinha um sistema que previa crises. Até o início de 2014, esse sistema não indicava crise alguma. Hoje sabemos que ele estava errado e falhou.

Entretanto, volto a dizer que nosso objetivo é tornar a discussão pública sobre esse gravíssimo problema mais qualificada. Criamos um site, totalmente público, para que todos possam ter acesso a essa informação. Não queríamos simplesmente publicar mais um artigo científico; queríamos contribuir para a resolução de um problema na sociedade.

Continue Reading | Comments Off on Entrevista: Roberto Kraenkel

Cem anos da Relatividade Geral

Teoria, proposta por Albert Einstein em 1915, revolucionou a Física e mudou a maneira de entender o espaço, o tempo, a luz e o universo

A Teoria da Relatividade Geral, proposta por Albert Einstein em 1915, revolucionou a Física e mudou a maneira como nós entendemos o espaço, o tempo, a luz e o universo. Cem anos depois ela continua a ter uma importância fundamental, e prevê fenômenos, como as ondas gravitacionais, que foram detectadas indiretamente apenas na década de 70. Entretanto, há observações que a teoria não explica. Além de ser incompatível com a Mecânica Quântica, a Relatividade Geral não prevê a expansão acelerada do universo e não descreve corretamente a velocidade de rotação de estrelas em torno do centro de galáxias. A melhor solução para esses mistérios são a energia escura e a matéria escura, substâncias cujas existências ainda não foram comprovadas.

“Matéria escura e energia escura são maneiras de entender certas anomalias”, diz Scott Dodelson, pesquisador norte-americano do Fermilab e professor na Universidade de Chicago. “Na verdade, elas podem nem mesmo existir. Pode ser que a nossa compreensão da gravidade esteja errada e que a teoria da Relatividade Geral precise ser modificada para que possamos entender o que observamos. Atualmente, uma pergunta fundamental é: será que precisamos modificar a teoria ou será que essas substâncias realmente existem?”

Matéria e energia escura

Uma das anomalias citadas por Dodelson é a velocidade com que estrelas giram em torno do centro de galáxias. A velocidade real é maior do que a prevista pela teoria para a quantidade de matéria que conseguimos ver – a matéria gera força gravitacional, responsável pelo movimento das estrelas. Quanto mais matéria, maior a velocidade de rotação.

Recentemente esse fenômeno foi comprovado também entre o Sol e o centro da Via Láctea. O trabalho foi feito por Fabio Iocco, do IFT/Unesp e do ICTP-SAIFR, em colaboração com pesquisadores europeus.

Foto da Via Láctea vista do hemisfério sul; o círculo azul no centro ilustra onde haveria matéria escura, de acordo com o estudo de Iocco.

“Há uma possibilidade de a matéria escura não existir, mas, para mim, ela é atualmente a melhor explicação, pois descreve o problema para diferentes escalas e corpos astronômicos”, diz Iocco. “Não sabemos exatamente o que ela é, mas sabemos que é matéria, por gerar força gravitacional, e que não interage com luz. Acredito que nosso trabalho contribuirá com estudos que buscam compreender o que a matéria escura realmente é e como ela está distribuída no universo”.

Outra anomalia é a aceleração de expansão do universo. Para a Relatividade Geral o universo não poderia estar acelerando, pois a matéria como a conhecemos atrai outros corpos, o que desaceleraria a expansão. Os físicos atribuem a aceleração à chamada energia escura, que continua a ser um mistério para a ciência.

Ondas gravitacionais

Uma das previsões corretas da Relatividade Geral são as ondas gravitacionais. Antes da teoria, acreditava-se que o efeito da gravidade era instantâneo. Para isso, a velocidade de propagação da força teria que ser infinita. Em sua Teoria da Relatividade Especial, contudo, Einstein previu que nada viaja em velocidades superiores à da luz. A gravidade teria que se propagar através das ondas gravitacionais.

Por interagirem muito fracamente com a matéria, essas ondas são difíceis de detectar. A comprovação de que elas existiam foi feita em 1974 por Russell Hulse e Joseph Taylor, ao notarem que a órbita de duas estrelas de nêutrons, que giravam uma ao redor da outra, estava diminuindo. O sistema estava perdendo energia, que era liberada na forma de ondas gravitacionais.

Atualmente, grandes experimentos, como o Virgo, na Itália, e o LIGO, nos Estados Unidos, tentam fazer a detecção direta dessas ondas. Como elas causam uma perturbação no espaço ao se propagar, é possível notar seu efeito em um sistema preciso de lasers e espelhos – a onda alteraria a distância entre os espelhos, em cerca de um milionésimo de um bilionésimo de metro, e o tempo para o laser completar o circuito mudaria.

“A detecção direta de ondas gravitacionais seria importante por diversos motivos”, diz Riccardo Sturani, pesquisador do ICTP-SAIFR e membro da colaboração LIGO. “Poderíamos ver corpos que não emitem luz, mas que emitem ondas gravitacionais, e poderíamos comparar as ondas observadas com as previstas pela Relatividade Geral para verificar se a teoria está realmente correta”.

Relatividade Especial e Relatividade Geral

A Teoria da Relatividade Especial foi formulada por Einstein e outros pesquisadores em 1905 e revolucionou a Física por mudar a forma como vemos o tempo e o espaço.

“Na física Newtoniana esses conceitos eram absolutos”, diz o físico Alberto Saa, da Unicamp. “Ou seja, independentemente de você estar parado ou em movimento, o tempo passa de forma igual e o espaço é o mesmo. Já a Relatividade Especial, como o próprio nome diz, mostrou que o tempo e o espaço são relativos – eles dependem do observador e de sua velocidade. Quanto mais alta a velocidade de um corpo, mais devagar o tempo passará para ele, e mais o espaço se contrairá à sua frente”.

Depois, com Teoria da Relatividade Geral, a gravidade deixou de ser vista como uma interação entre corpos e passou a ser vista como uma deformação no espaço-tempo. A massa de um corpo é responsável por causar uma curvatura que afeta o movimento de outros corpos, atraindo-os para perto de si. Quanto maior a massa, maior a deformação.

Além disso, para Newton, a força gravitacional não influenciava a luz. Já para Einstein, massa e energia são equivalentes – como diz sua famosa equação, energia é igual a massa multiplicada pela velocidade da luz ao quadrado, ou E = mc2. Assim, a trajetória de um feixe de luz pode ser alterada pela gravidade.

Uma importante aplicação dessas teorias está nos Global Positioning Systems, os GPSs. Como os satélites que estão em órbita da Terra estão sujeitos a uma força gravitacional diferente da nossa, a teoria de Einstein prevê que seus relógios andariam mais rápido. Quando o primeiro satélite de GPS foi colocado em órbita, o fenômeno foi comprovado experimentalmente. Sem os ajustes que a teoria propõe, o GPS não funcionaria.

Outras teorias

A Relatividade Geral explica fenômenos de escalas macroscópicas, porém não se sabe como aplicá-la em escalas subatômicas. Para estudar esses fenômenos, a Mecânica Quântica é usada. A conciliação entre as duas é um grande desafio para a Física, e algumas teorias, formuladas ao longo do último século, caminham nessa direção.

A Gravitação Teleparalela, ou Teleparalelismo, é uma delas. Criada na década de 50, ela descreve a gravitação através da torção do universo, e não através da curvatura, como a Relatividade Geral. O Teleparalelismo se encaixa dentro do esquema das Teoria de Gauge, que explicam, por relações de simetria, as demais interações da natureza – a eletromagnética, a Força Fraca e a Força Forte.

“Uma das principais características do teleparalelismo é que, diferente da Relatividade Geral, ele permite separar a gravitação de efeitos inerciais”, diz José Geraldo Pereira, pesquisador do IFT/Unesp que, junto com Ruben Aldrovandi, contribuiu para a consolidação da teoria e escreveu o primeiro livro dedicado exclusivamente a ela, Teleparallel Gravity: An Introduction, publicado em 2012. “Podemos, assim, definir inequivocamente a energia do campo gravitacional, o que é impossível com a Relatividade Geral. O teleparalelismo também parece ser mais apropriado para estudar fenômenos gravitacionais na escala quântica”.

A Teoria das Cordas também é bastante estudada e tenta complementar a Relatividade Geral para explicar a gravitação na escala quântica. Elaborada na década de 70, ela também é baseada em simetrias e prevê que as partículas são espécies de cordas unidimensionais que estão em constante vibração.

“Atualmente, a Teoria das Cordas é o modelo mais bem aceito para unir a Relatividade Geral com a Mecânica Quântica”, diz Nathan Berkovits, diretor do ICTP-SAIFR e pesquisador do IFT/Unesp. “Com ela conseguimos prever o espalhamento de ondas gravitacionais, incluindo os efeitos quânticos”.

Para Dodelson, a unificação das teorias é um problema teórico, pois não há observações que exijam que elas sejam conciliadas. O pesquisador acredita que ao longo da próxima década, com experimentos em escalas maiores, obteremos mais dados e alguns modelos serão eliminados. A busca por uma “teoria de tudo” continuará.

“Um grande triunfo da Física é sua habilidade de explicar uma abrangente gama de fenômenos com algumas poucas leis”, diz ele. “Esse reducionismo atingiria o seu limite se todas as leis pudessem ser unificadas em uma única teoria. O problema é que, na maioria dos casos, a unificação de ideias é difícil, quando não é impossível, de se testar”.

*Texto publicado na revista Unesp Ciência, número 62, abril/2015. Veja a versão em PDF clicando aqui.

Continue Reading | Comments Off on Cem anos da Relatividade Geral

ICTP-SAIFR faz novas parcerias com institutos europeus

Acordos com centros de pesquisa em física teórica de Madrid e Paris promoverão intercâmbio de alunos e professores e organização de eventos

O ICTP-SAIFR assinou, em março, dois novos acordos internacionais que irão facilitar e promover colaborações com o Institut de Physique Théorique (IPhT) CEA-Saclay, de Paris, e o Instituto de Física Teórica UAM-CSIC, de Madrid. As parcerias encorajarão o intercâmbio de alunos de doutorado, pós-doutorado e professores entre os centros de pesquisa, e a organização de cursos e workshops em áreas de comum interesse. Os acordos têm uma duração inicial de dois anos, mas há a possibilidade de renovação por um período de mais dois anos.

Intercâmbio e eventos

Um dos principais aspectos das parcerias é a promoção de intercâmbios, com o objetivo de estimular a criação de vínculos e colaborações internacionais entre alunos e pesquisadores desses institutos.

Entre as áreas de pesquisa de maior interesse do IPhT, destacam-se física de altas energias, física matemática, matéria condensada, gravidade quântica e teoria das cordas. Já o instituto espanhol se concentra mais em áreas como cosmologia e astrofísica.

Além dos intercâmbios, as parcerias também estimularão professores de todos os centros de pesquisa a proporem e organizarem projetos de pesquisa e eventos em conjunto, como workshops e cursos. Para isso, cada instituto terá um coordenador que irá receber as propostas e julgá-las.

Para saber mais, os acordos, e todas as informações sobre eles, podem ser acessados no site do ICTP-SAIFR.

Outros acordos

O ICTP-SAIFR também renovou recentemente acordos com o CERN e o Perimeter Institute, do Canadá.

A parceria com o CERN, que abriga o LHC – atualmente o maior acelerador de partículas do mundo -, estimulará colaborações na área de Física de Partículas e promoverá intercâmbios com o centro de pesquisa da Suiça. Já a parceria com o Perimeter Institute, que proporcionou eventos no ICTP-SAIFR como o “Programa em Integrabilidade, holografia e o Conformal Bootstrap” e um minicurso sobre Teoria Quântica de Campos, encorajará pesquisas na área de Teoria de Campos.

O ICTP-SAIFR ainda possui acordos em andamento com outros grandes centros de pesquisa em física teórica do mundo. Entre eles, além do ICTP-Trieste, se destacam o Fermilab, em Chicago – maior centro de pesquisa em Física de Partículas do continente, com o qual o ICTP-SAIFR realizará um curso sobre neutrinos em agosto desse ano – e o NORDITA (Instituto de Física Teórica Nórdico), que tem sede na Suécia e faz pesquisas em diversas áreas, como astrofísica, matéria condensada e física de altas energias.

Continue Reading | Comments Off on ICTP-SAIFR faz novas parcerias com institutos europeus