ICTP-SAIFR celebra 12 anos aproximando alunos e pesquisadores em Física do mundo inteiro

Instituto sediado no IFT-Unesp, inspirado em centros internacionais de excelência, expande suas atividades a partir de 2025

O ano de 2024 marca o 12º aniversário do Instituto Sul-Americano para Pesquisa Fundamental (ICTP-SAIFR), centro internacional sediado no Instituto de Física Teórica (IFT) da Unesp, em colaboração com a Fapesp e o Centro Internacional de Física Teórica (ICTP). Desde sua criação, o instituto recebeu cerca de 9 mil estudantes e pesquisadores visitantes em mais de 350 escolas, workshops e outras atividades presenciais. Também possui uma programação voltada a tornar a Física mais acessível a diversos segmentos da sociedade. “Seguindo o modelo do ICTP, e com o apoio da Fapesp e Unesp e fontes privadas, conseguimos criar um polo onde alunos e pesquisadores da América do Sul podem interagir diretamente com físicos renomados do mundo inteiro”, destaca Nathan Berkovits, professor do IFT e diretor do ICTP-SAIFR.

Para celebrar a efeméride, o instituto realizou, dos dias 18 a 20 de fevereiro, um simpósio com cientistas de diversas partes do mundo, que incluiu palestras para os públicos geral e especializado, bem como discussões sobre centros de Física e a próxima fase do ICTP-SAIFR, com a expansão das suas atividades a partir de 2025.

A vice-reitora da Unesp, Maysa Furlan, iniciou a cerimônia de abertura enfatizando como o ICTP-SAIFR é primordial para “a internacionalização da universidade”, definido por ela como um “processo transformador”, e ressaltou o “conhecimento qualificado” gerado pelo instituto e registrado em publicações científicas. Na sequência, o presidente da Fapesp, Marco Antonio Zago, afirmou que é objetivo da agência fazer do ICTP-SAIFR “o mais importante hub de Física na América Latina”. Ele também reiterou a determinação do órgão em “apoiar fortemente o SAIFR, expandir seu cronograma anual de reuniões e seminários, bem como criar um novo formato para juntar cientistas para discutir e propor soluções às temáticas que são centrais” para o instituto.

Os 12 anos do ICTP-SAIFR coincidem com os 60 anos do ICTP, fundado em Trieste (Itália) por Abdul Salam, físico paquistanês laureado com o Nobel em 1979. “A ideia original do ICTP era realmente criar um centro internacional de ciência, onde pesquisadores de todo o mundo pudessem se reunir para ajudar a tornar a ciência globalmente disponível e superar as barreiras de gênero e etnia”, e também geográficas e econômicas, explica Atish Dabholkar, diretor do ICTP. Nesse sentido, o ICTP-SAIFR – o primeiro dos atuais quatro institutos regionais parceiros do ICTP – reproduz localmente, na América do Sul, o que o ICTP realiza globalmente.

A presença do ICTP no Brasil, especificamente em São Paulo, “cria um ambiente internacional imprescindível para que nós possamos desenvolver conhecimento”, afirma Vahan Agopyan, secretário estadual de Ciência, Tecnologia e Inovação. “No mundo globalizado, os centros de pesquisa e desenvolvimento necessariamente têm que ser internacionalizados. Para fazer essa internacionalização, não basta apenas a mobilidade dos alunos ou dos professores”, diz o secretário. “Nós temos que trazer as instituições do exterior para trabalhar aqui junto conosco”.

O ICTP-SAIFR também “tem tido um papel importante na Física brasileira” na visão de Rodrigo Capaz, professor da UFRJ e presidente da Sociedade Brasileira de Física (SBF), devido à “realização de eventos, seminários, escolas” para pesquisadores, além das atividades para público geral e outras ligadas ao ensino de Física. Ele também menciona as missões complementares entre ambas as instituições, que “podem trabalhar juntas numa grande variedade de agendas”.

O modelo de funcionamento do ICTP-SAIFR é inspirado no de outros centros internacionais de excelência, como o Instituto Kavli de Física Teórica (KITP), nos EUA. David Gross, prêmio Nobel de Física de 2004 e ex-diretor do KITP, aponta pelo menos três razões para o sucesso de institutos como o ICTP-SAIFR. A primeira é que cientistas “amam se encontrar e conversar”: “Nós temos tempo para trocar ideias, explicar o que estamos fazendo, discutir com nossos colegas. Essa é a melhor forma de fazer ciência teórica”.

A segunda razão é que esses centros conseguem juntar “pessoas de diferentes campos – o que não é fácil de fazer em universidades tradicionais com departamentos – e isso pode transformar campos, que aprendem de outros campos, e muitas vezes criar novos campos”, indica David Gross. A terceira é que, para jovens pesquisadores, esses institutos são um “ótimo ambiente de treinamento” por expô-los a diversas atividades em suas próprias áreas e, ainda mais importante, em outras que não dominam.

A seleção dos eventos realizados pelo instituto é uma das responsabilidades do seu Conselho Científico, formado na maior parte por pesquisadores externos ao instituto, de diferentes países. Para André de Gouvêa, da Universidade Northwestern (EUA) e membro do conselho, isso respalda e aumenta a respeitabilidade do ICTP-SAIFR, na medida em que essas pessoas estão interessadas no sucesso do instituto, mas sem se envolver com a sua gestão. Ele acrescenta que o grupo é composto por especialistas de diferentes áreas, o que colabora para o surgimento de “ideias novas o tempo todo”.

O também membro do Conselho Científico e pesquisador do Instituto Perimeter (Canadá), Luis Lehner, reforça que, além dos eventos de pesquisa, o ICTP-SAIFR vem promovendo ações de divulgação científica, como atividades para professores e estudantes do Ensino Médio baseadas em material produzido pelo Perimeter e traduzido para português e espanhol pelo ICTP-SAIFR. O pesquisador acredita que esta é “uma forma de realmente fortalecer a visão de que a ciência, e a Física em particular, é muito democrática e só podemos melhorar tentando envolver todos os níveis da sociedade”. Outras ações incluem exibições e debates de filmes com temas relacionados à ciência e palestras de pesquisadores renomados voltadas ao público geral.

Na nova fase do ICTP-SAIFR, a partir de 2025, suas atividades serão expandidas para incluir programas de longa duração nas áreas de Física da Vida, Física Fundamental e Sistemas Quânticos/Inteligência Artificial. “Planejamos iniciar programas semelhantes aos do KITP com especialistas convidados e muito tempo para discussão, que estimulem colaborações entre pesquisadores locais e os cientistas visitantes”, anuncia Nathan Berkovits, diretor do ICTP-SAIFR.

Felipe Saldanha é coordenador de comunicação e jornalista de ciência do ICTP-SAIFR com bolsa Fapesp. Colaboraram Ana Luiza Sério e Celina Lerner (ICTP-SAIFR).

***

Assista ao vídeo com os melhores momentos do simpósio do 12º aniversário do ICTP-SAIFR:

Continue Reading | Comments Off on ICTP-SAIFR celebra 12 anos aproximando alunos e pesquisadores em Física do mundo inteiro

Eventos do ICTP-SAIFR abordam diversidade e inclusão na Física

“Increasing Diversity” teve foco em ações de desenvolvimento de carreira e “Boost STEM” apresentou iniciativas nacionais e internacionais

Por Felipe Saldanha (ICTP-SAIFR), com colaboração de Ana Clara Moreira (ICTP-SAIFR)*

Na semana de 13 a 17 de novembro, o ICTP-SAIFR realizou dois workshops sobre diversidade e inclusão no Instituto de Física Teórica (IFT) da Unesp, na cidade de São Paulo. O primeiro foi o “Increasing Diversity and Inclusion in Science” (Aumentando a Diversidade e a Inclusão na Ciência), que teve o objetivo de fornecer ferramentas de apoio para as carreiras de alunos e jovens pesquisadores pertencentes a grupos com baixa representação. O segundo foi o “Proposals to Boost STEM Participation in Underrepresented Groups” (Propostas para Aumentar a Participação STEM de Grupos Sub-representados), com o intuito de discutir iniciativas no Brasil, Argentina e EUA que contribuem para aumentar a diversidade na ciência com foco nas populações afrodescendentes, indígenas e de baixa renda.

O primeiro evento teve palestras plenárias de pesquisadoras em diferentes estágios profissionais: Sendy Melissa Santos do Nascimento, da Universidade Federal de Alagoas (UFAL); Sônia Guimarães, do Instituto de Tecnologia Aeronáutica (ITA); e Renata Wasserman, da Universidade de São Paulo (USP). Sendy Nascimento falou sobre sua carreira e mulheres negras que a inspiram, como a matemática Katherine Johnson, uma das responsáveis pelo tráfego aéreo como se conhece hoje. Sônia Guimarães e Renata Wasserman explanaram sobre suas trajetórias profissionais nas suas instituições e as barreiras que enfrentam. Houve ainda dois painéis de discussão. O primeiro, intitulado “Inclusão e diversidade em Ciência e Tecnologia: uma iniciativa para igualdade e desenvolvimento”, teve mediação de Zélia Maria Da Costa Ludwig, da Universidade Federal de Juiz de Fora (UFJF), e o segundo teve como título “Gênero e transição tecnológica na América Latina” e como mediadora Alba Avila-Bernal, da Universidade dos Andes (Colômbia).

Também integrou a programação uma edição especial do Ciência no Cinema, com exibição do filme Estrelas Além do Tempo no Cine Belas Artes, no dia 14, seguida de debate com Zélia Ludwig, da UFJF. No debate, a professora comentou sobre meritocracia, as dificuldades que mulheres negras têm ao acessar espaços acadêmicos e como elas são silenciadas. Ela acrescentou: “Precisamos empoderar as mulheres para que elas possam acreditar que podem e conseguem, e precisamos fazer isso juntas”.

O primeiro dia do segundo evento, Boost STEM (sigla em inglês para Ciência, Tecnologia, Engenharia e Matemática), foi voltado a experiências internacionais. Young-Kee Kim, presidente eleita da Sociedade Americana de Física (APS), mostrou como a instituição tem trabalhado para aumentar a inclusão e abraçar diversas perspectivas. Silvina Ponce Dawson, presidente designada da União Internacional de Física Pura e Aplicada (IUPAP), falou sobre ações desta entidade para ampliar a inclusão e a diversidade na Física.

Jim Gates, ex-presidente da APS e ganhador da Medalha Nacional da Ciência dos EUA, ofereceu um relato de sua própria vida enquanto homem negro, mostrando como tem desafiado barreiras e vivido a diversidade em STEM. Por fim, Valeria Viva, cofundadora da XSTEM (Argentina), dissertou sobre como a sua organização tem aplicado a educação STEM para adolescentes. As discussões foram finalizadas com uma mesa-redonda com a participação dos palestrantes.

O segundo dia deu destaque a iniciativas brasileiras. Maria Lucia Santana Braga, analista e membro da equipe do Programa Mulher e Ciência do CNPq, apresentou o Painel de Fomento em Ciência, Tecnologia e Inovação, que consegue, pela primeira vez, detalhar com dados explícitos a proporção no Brasil dos gêneros e etnicidades nos vários níveis da carreira. Lazaro Cunha, diretor do Instituto Steve Biko e coordenador do Oguntec, explicou o funcionamento do projeto, uma experiência de ações afirmativas na educação científica de jovens negros de escolas públicas da Bahia. Rogerio Monteiro de Siqueira, da Escola de Artes, Ciências e Humanidades da USP, explanou sobre o programa de pós-doutorado para pesquisadores negros nesta universidade, e Celso Lins de Oliveira, da Faculdade de Zootecnia e Engenharia de Alimentos da USP, abordou as barreiras e a sub-representação negra na docência do Ensino Superior.

Na sequência, houve uma mesa-redonda com todos os palestrantes do dia, que incluiu também Rodrigo Barbosa Capaz, presidente da Sociedade Brasileira de Física (SBF), e Marcelo Knobel, ex-reitor da Universidade Estadual de Campinas (Unicamp). Capaz citou iniciativas da SBF como os prêmios Anselmo Salles Paschoa (outorgado a pessoas negras em início de carreira na pesquisa em Física) e Carolina Nemes (para mulheres físicas em início de carreira) e a Comissão JEDI – Justiça, Equidade, Diversidade e Inclusão, presidida por Sônia Guimarães. Knobel discutiu o Programa de Formação Interdisciplinar Superior (ProFIS), projeto que já preparou mais de mil estudantes de Ensino Médio, vindos de escolas públicas de Campinas, para ingressar na Unicamp.

“O Boost STEM foi um evento essencial para ouvir as demandas da comunidade e melhor planejar atividades futuras, com atenção especial aos grupos sub-representados como a população negra, o povo indígena, as pessoas de baixa renda, mulheres e outras identidades de gênero”, afirma Karen Hallberg, do Instituto Balseiro (Argentina), uma das organizadoras do evento e membro do conselho científico do ICTP-SAIFR. As gravações das transmissões ao vivo e materiais de apoio do Increasing Diversity e do Boost STEM estão disponíveis no site do ICTP-SAIFR.

*Felipe Saldanha e Ana Clara Moreira são bolsistas Fapesp de Jornalismo Científico no ICTP-SAIFR.

Continue Reading | Comments Off on Eventos do ICTP-SAIFR abordam diversidade e inclusão na Física

Escola prepara futuros líderes da pesquisa em Física

“Journeys”, curso do ICTP-SAIFR/IFT-Unesp com Instituto Perimeter (Canadá) para graduandos de alto desempenho, oferece formação de ponta, networking e a chance de cursar mestrado em conjunto com um instituto de excelência no exterior

Por Felipe Saldanha

Neste exato momento, alguns dos pesquisadores em Física propensos a se tornarem os mais importantes da próxima geração ainda estão cursando a graduação. Para aumentar as chances de sucesso em suas carreiras, é preciso identificá-los, oferecer oportunidades de aperfeiçoamento e envolvê-los em colaborações internacionais. É com este intuito que, em julho, o ICTP-SAIFR, o Instituto de Física Teórica (IFT) da Unesp e o Instituto Perimeter de Física Teórica (Canadá) realizaram a sexta edição do Journeys into Theoretical Physics.

A origem do Journeys remete às Jornadas da Física Teórica, evento realizado pelo IFT-Unesp nas últimas três décadas como forma de divulgar os trabalhos desse instituto – cujos alunos são todos de pós-graduação – para estudantes de graduação de São Paulo. No formato atual, o propósito inicial foi expandido e, agora, o Journeys busca alcançar alunos de toda a América Latina, tendo como um dos principais atrativos a oportunidade de ingresso em um mestrado internacional conjunto entre ICTP-SAIFR/IFT-Unesp e Perimeter. As inscrições para a próxima edição têm abertura prevista para o início de 2024.

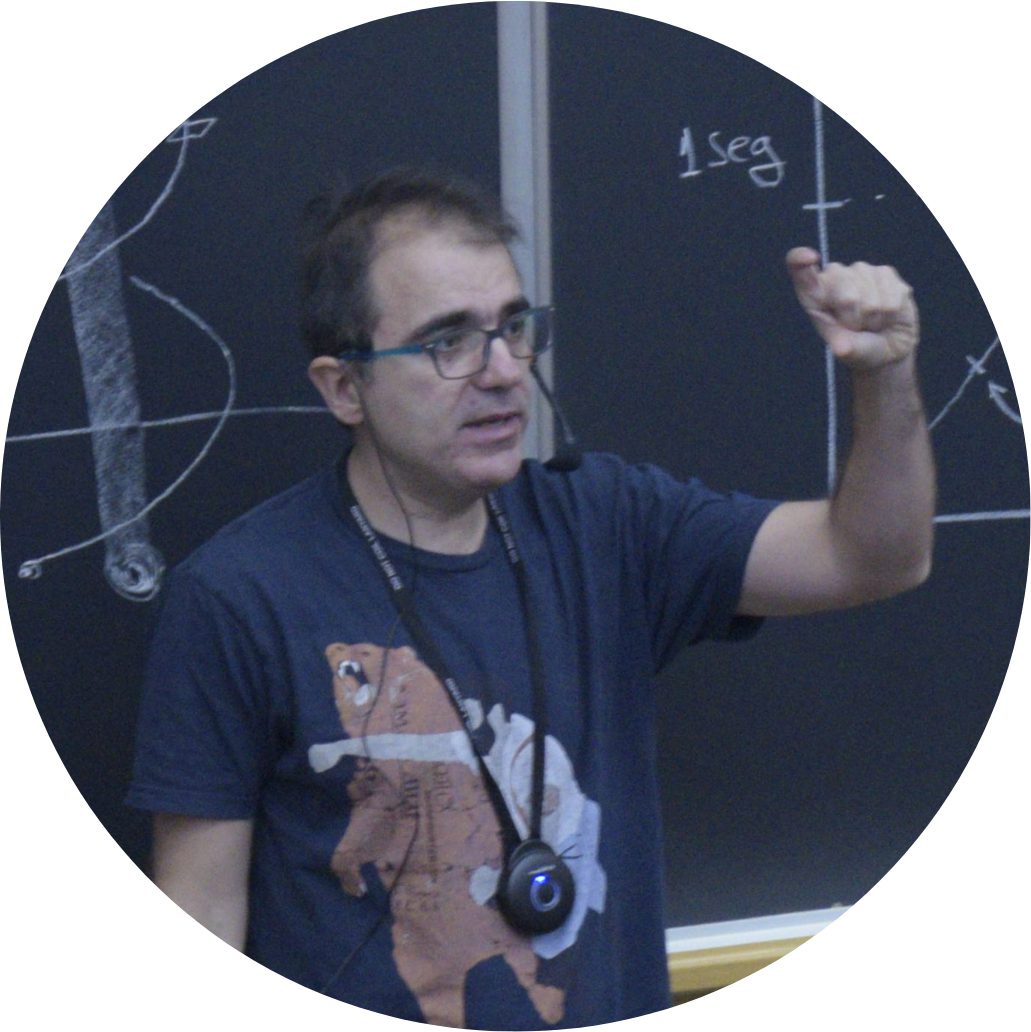

O físico Pedro Vieira (foto à esquerda), coordenador da parceria Perimeter-SAIFR-IFT e professor em conjunto das duas instituições, explica que o Journeys procura alunos com desempenho excepcional em fim de curso e, por isso, impõe exigências desde o processo seletivo, que requer dos candidatos uma declaração de interesse, histórico escolar e cartas de recomendação de professores. Estudantes de fora da cidade de São Paulo podem solicitar ajuda de custo, que cobre hospedagem, transporte e alimentação.

O físico Pedro Vieira (foto à esquerda), coordenador da parceria Perimeter-SAIFR-IFT e professor em conjunto das duas instituições, explica que o Journeys procura alunos com desempenho excepcional em fim de curso e, por isso, impõe exigências desde o processo seletivo, que requer dos candidatos uma declaração de interesse, histórico escolar e cartas de recomendação de professores. Estudantes de fora da cidade de São Paulo podem solicitar ajuda de custo, que cobre hospedagem, transporte e alimentação.

A programação do Journeys, ofertada por professores do ICTP-SAIFR/IFT-Unesp e do Perimeter, cobre quatro tópicos de Física Teórica em nível básico, de modo um pouco menos avançado que as escolas tradicionalmente promovidas pelo ICTP-SAIFR, mas com temas que avançam o currículo da graduação (leia mais no box ao fim deste texto). Após cinco dias de palestras, os alunos são submetidos a dois dias de rigorosos exames escritos, que funcionam tanto como ferramenta de aprendizado quanto mecanismo de seleção para o mestrado internacional. Em 2023, os selecionados para esse mestrado foram Francisco Divi, do Instituto Balseiro, na Argentina; Matheus Balisa Pauliquevis, do Instituto de Física da Universidade de São Paulo (IFUSP); e Levy Bruno do Nascimento Batista, do Instituto de Física de São Carlos (IFSC/USP).

Para Vieira, o Journeys amplifica o “grau da colaboração” entre ICTP-SAIFR/IFT-Unesp e Perimeter ao ir além de um simples memorando de entendimento e proporcionar a formação de uma “massa crítica”. Ele ainda destaca que o Journeys proporciona vantagens para todos os envolvidos. Para o ICTP-SAIFR/IFT-Unesp, por atrair “esses alunos que seria muito difícil atrair de outra forma, que são de fato de topo e iriam para outras universidades de topo”. Para o Perimeter, que recebe estudantes que costumam ficar entre os melhores da instituição canadense. E para os próprios alunos, que “não têm acesso a nenhum mecanismo para se distinguirem como têm nesta escola”.

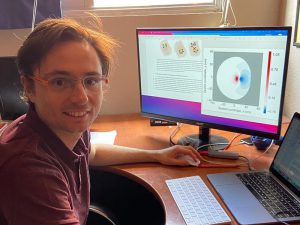

Lua Figueiredo (esq.) e Dario Escriba (dir.): alunos do Journeys fazem networking e se aprofundam em tópicos diversos

O Journeys é igualmente uma oportunidade de fazer networking. Vieira conta que os alunos são encorajados a “ir bater à porta das pessoas enquanto aqui estão para descobrir potenciais supervisores para o futuro”. Aproximar-se de professores reconhecidos na área, do Brasil e da América Latina, foi justamente um dos motivos para a graduanda do IFUSP Lua Figueiredo ter optado por participar da escola por dois anos consecutivos. Ela ainda aproveitou o evento para se aprofundar em matérias com as quais não é tão familiarizada e “ver o que se faz nas outras áreas”.

Motivos semelhantes trouxeram ao Journeys, também pela segunda vez, o graduando Dario Escriba, da Universidade Nacional Maior de São Marcos (Peru). Ele afirma que os tópicos abordados na escola não costumam ser discutidos nos países em desenvolvimento. O estudante considerou o conteúdo como denso e difícil de “resumir e revisar” em poucas horas de aula, mas apontou como “muito útil” a disponibilização das gravações no YouTube.

Vieira aponta que o Journeys estabelece “uma noção de grupo entre os alunos, porque serão os futuros líderes da Física da América Latina” e muitas vezes vão se conhecer pela primeira vez no evento, o que “vai certamente ter um impacto no futuro, de criar um sentido de comunidade e um sentido de colaboração”. Assim, é possível que estudantes como Figueiredo e Escriba se tornem, dentro de alguns anos, coordenadores de algumas das escolas avançadas do ICTP-SAIFR.

Felipe Saldanha é jornalista de ciência do ICTP-SAIFR com bolsa Fapesp.

INTRODUÇÕES E APROFUNDAMENTOS

Tópicos abordados na escola unem o básico às discussões mais contemporâneas da Física Teórica

Introdução à supersimetria

Nathan Berkovits, ICTP-SAIFR / IFT-Unesp

Formulada há 50 anos como uma generalização das simetrias de espaço-tempo, mas com novas coordenadas para além das quatro mais conhecidas (as três dimensões espaciais e uma temporal), a supersimetria – aplicada à gravidade – “parece ser a única maneira para unificar a Relatividade Geral com Mecânica Quântica sem encontrar inconsistências”, aponta Berkovits. “Mas, até agora, os experimentos não encontraram evidências para essa nova simetria. Então ainda está incerto se a supersimetria vai ser relevante para entender a Física do nosso universo”.

Aprendizado de máquina para matéria quântica

Juan Carrasquilla, Instituto Vector para Inteligência Artificial (Canadá)

Avanços na inteligência artificial (IA) estão revolucionando as ciências da natureza em geral e a Física em particular, com ferramentas para facilitar a compreensão de fenômenos naturais mais precisas que as técnicas tradicionais. No caso específico da matéria quântica, “a IA desempenha um papel fundamental no tratamento de grandes volumes de dados por meio do reconhecimento de padrões, produzindo insights mais profundos a partir de dados experimentais de imagens eletrônicas”, explica Carrasquilla. Para o pesquisador, a união entre IA e Física “abre novos caminhos de exploração, permitindo-nos enfrentar problemas complexos de forma mais eficiente”.

Introdução ao efeito Hall quântico

Yin-Chen He, Instituto Perimeter de Física Teórica (Canadá)

“O efeito Hall quântico é um belo exemplo de como os sistemas do mundo real podem exibir fenômenos quânticos notáveis em escala macroscópica, contrastando com o reino microscópico usual onde ocorrem fenômenos quânticos”, diz He. De acordo com o pesquisador, este efeito está envolvido em ideias e subcampos de Física e Matemática que estão na vanguarda da pesquisa. Entre as suas potenciais aplicações tecnológicas, está “a construção de computadores quânticos livres de erros, conhecidos como computadores quânticos topológicos. Este campo ainda é uma área de pesquisa ativa e contínua”, conclui He.

Problemas em aberto na Física de Partículas

Ricardo Matheus, IFT-Unesp

Neste curso, Matheus parte de algo bem estabelecido na Física, o modelo padrão, que combina dois dos pilares fundamentais da Física contemporânea – a quântica e a relatividade – para descrever “não somente as partículas subatômicas (de que tudo que vemos é feito) mas também suas interações, dando assim conta das três forças fundamentais que importam neste mundo pequenino”. A partir daí, segundo o pesquisador, “podemos discutir também tudo aquilo que ele não explica: a massa dos neutrinos e a matéria escura, ambos problemas ainda sem solução”.

Continue Reading | Comments Off on Escola prepara futuros líderes da pesquisa em Física

Ricardo Martínez-García ganha prêmio internacional de carreira em pesquisa de sistemas complexos

Jovem pesquisador do CASUS e SAIFR foi reconhecido por seu trabalho em Física Estatística para melhor compreender a dinâmica de sistemas vivos complexos

Foto: Divulgação/CSS

O físico Ricardo Martínez-García é um dos dois ganhadores do Prêmio Científico Júnior 2023 da Sociedade de Sistemas Complexos (CSS). A CSS concede esse prêmio a jovens investigadores que tenham alcançado resultados notáveis na sua busca pela compreensão de sistemas complexos. O anúncio foi feito em 20 de outubro durante a conferência anual da CSS, o maior e mais importante encontro internacional do mundo para a comunidade de pesquisa de sistemas complexos. Martínez-García atualmente lidera um Grupo de Jovens Pesquisadores no Centro para Compreensão de Sistemas Avançados (CASUS) em Helmholtz-Zentrum Dresden-Rossendorf (HZDR, ambos na Alemanha) e é pesquisador associado no Instituto Sul-Americano para Pesquisa Fundamental (ICTP-SAIFR) e no Instituto de Física Teórica da Universidade Estadual Paulista (IFT-Unesp).

O que têm em comum o tráfego de veículos, o cérebro, a sociedade humana e o microbioma? Todos esses são exemplos de sistemas complexos formados por muitos componentes interagindo entre si de maneiras muito intricadas. Como resultado destas interações, tais sistemas exibem frequentemente novas propriedades emergentes que são muito diferentes das propriedades combinadas das partes individuais que os constituem. A pesquisa em sistemas complexos constrói pontes entre domínios científicos tradicionais.

Essa é também uma característica distinta do trabalho de Martínez-García, que estuda uma variedade de sistemas, desde comunidades microbianas, como biofilmes bacterianos, até ecossistemas áridos e semiáridos como as estepes. Através dessa variedade de sistemas, sua investigação concentrou-se na compreensão de como diferentes organismos, sejam espécies de plantas numa estepe ou bactérias num biofilme, interagem entre si e como essas interações impactam o funcionamento do sistema como um todo. Ao estudar todos esses exemplos utilizando uma abordagem de sistemas complexos, a investigação de Martínez-García visa compreender até que ponto os diferentes sistemas ecológicos são governados por um conjunto mínimo de regras, o que melhorará a nossa capacidade de os manipular e, esperançosamente, de os conservar.

Comitê de Seleção destaca o trabalho de Martínez-García sobre dinâmica organizacional

A Sociedade de Sistemas Complexos promove a investigação de sistemas complexos desde que se tornou uma sociedade internacional em 2006. O seu Prémio Científico Júnior visa reconhecer o excelente desempenho científico de jovens investigadores nos 10 anos após a defesa do doutoramento. É atribuído uma vez por ano a um máximo de dois jovens investigadores. A decisão é tomada por uma Comissão de Seleção nomeada pela Comissão Executiva da CSS. Na declaração de premiação, o Comitê de Seleção fez referência ao trabalho teórico de Martínez-García sobre dinâmicas coletivas evolutivas, organizacionais e ecológicas.

Martínez-García afirma que seu interesse por sistemas ecológicos complexos começou por causa de seu amor por estar ao ar livre e observar como as coisas acontecem na natureza: “Quando aprendi no Ensino Médio que era possível usar a Física e a Matemática para entender as regras por trás desses fenômenos naturais pelos quais estava apaixonado, ficou evidente que eu queria explorar mais profundamente essa interface.”

Ele também destaca como as interações com colegas cientistas ajudaram a moldar seu programa de pesquisa ao longo dos anos: “Uma das partes que mais gosto no meu trabalho é conversar com pessoas com diferentes formações científicas e aprender como elas pensam sobre questões e problemas que eu também acho interessante.”

“Um trabalho fantástico”

O pesquisador acrescenta que o prêmio o incentiva a continuar trabalhando arduamente, um conselho que dá aos estudantes interessados em escolher a ciência como profissão – que é tão emocionante quanto desafiadora: “É muito gratificante ver que os seus pares reconhecem a relevância do seu trabalho e o consideram merecedor desse reconhecimento. Acredito que muitas vezes nos concentramos demais nas rejeições e nas desvantagens de seguir uma carreira científica, embora seja, em geral, um trabalho fantástico.”

Martínez-García obteve seu doutorado em Física Estatística e Sistemas Complexos no Instituto de Física Interdisciplinar e Sistemas Complexos (IFISC), um centro de pesquisa conjunto do Conselho Nacional de Pesquisa Espanhol (CSIC) e da Universidade das Ilhas Baleares (Espanha). Sua tese combinou abordagens da Física e das Ciências da Computação para investigar diferentes problemas ecológicos, como o movimento dos animais e o surgimento de padrões regulares de vegetação em terras áridas. Ele então recebeu uma bolsa da Fundação de Pesquisa em Ciências da Vida para concluir um pós-doutorado em Ecologia e Biologia Evolutiva na Universidade de Princeton (EUA), onde investigou a interação entre a ecologia, a evolução e a multicelularidade auto-organizada das comunidades microbianas. Antes de ingressar no CASUS, Martínez-García trabalhou no ICTP-SAIFR / IFT-Unesp. Lá, foi Jovem Pesquisador da Fapesp e Professor Assistente na área de Física Biológica.

Um segundo Prêmio Científico Júnior foi este ano para Giulia Menichetti (Harvard Medical School & Brigham and Women’s Hospital, Boston, EUA), que investiga toda a complexidade química da dieta humana e desenvolve ferramentas quantitativas para revelar o impacto destes produtos químicos na nossa saúde. Por último, o Comitê de Seleção concedeu o Prêmio Sênior, o mais prestigiado reconhecimento do CSS, este ano a Melanie Mitchell (Instituto Santa Fé, EUA) referindo-se, entre outras, às suas contribuições para a computação adaptativa, a computação de inspiração biológica e a aprendizagem automática.

Sobre o Centro para Compreensão de Sistemas Avançados

O CASUS foi fundado em 2019 em Görlitz (Alemanha) e realiza pesquisas interdisciplinares de sistemas com uso intensivo de dados em disciplinas tão diversas como pesquisa de sistemas terrestres, biologia de sistemas ou pesquisa de materiais. O objetivo do CASUS é criar imagens digitais de sistemas complexos de fidelidade sem precedentes à realidade com métodos inovadores de matemática, pesquisa de sistemas teóricos, simulações, bem como dados e Ciência da Computação para dar respostas a questões sociais urgentes. Os parceiros fundadores do CASUS são o Helmholtz-Zentrum Dresden-Rossendorf (HZDR), o Centro Helmholtz de Pesquisa Ambiental em Leipzig (UFZ), o Instituto Max Planck de Biologia Celular Molecular e Genética em Dresden (MPI-CBG), a Universidade Técnica de Dresden (TUD) e a Universidade de Wrocław (UWr). O CASUS, gerido como um instituto do HZDR, é financiado pelo Ministério Federal Alemão de Educação e Pesquisa (BMBF) e pelo Ministério da Ciência, Cultura e Turismo do Estado da Saxônia (SMWK). www.casus.science

Sobre o ICTP-SAIFR

O Instituto Sul-Americano para Pesquisa Fundamental (ICTP-SAIFR) é um centro internacional criado na cidade de São Paulo por meio de uma colaboração entre o Centro Internacional de Física Teórica (ICTP) em Trieste (Itália), o IFT-Unesp e a Fapesp. Suas atividades incluem pesquisa em Física Teórica e suas aplicações, bem como treinamento para alunos de pós-graduação. O ICTP-SAIFR também promove divulgação científica e ações de extensão junto a professores e estudantes de Ensino Médio e público geral. Mais informações estão disponíveis no site ictp-saifr.org.

Sobre o IFT-Unesp

O Instituto de Física Teórica (IFT) é um departamento de pós-graduação em Física da Unesp localizado no centro de São Paulo. O IFT-Unesp foi criado em 1951 como uma fundação privada e incorporado à Unesp em 1987. Possui aproximadamente 20 professores e 70 alunos de pós-graduação em Física, e recebe nota máxima da Coordenação de Aperfeiçoamento de Pessoal de Nível Superior (Capes) desde 2011.

Continue Reading | Comments Off on Ricardo Martínez-García ganha prêmio internacional de carreira em pesquisa de sistemas complexos

“Alça de bota”: um “truque” da Física para questões muito complexas

Técnica do bootstrap, que permite obter resultados a partir de princípios gerais, tem sido explorada por colaboração global de pesquisadores

Parte do calçado que deu nome ao conceito remete a processos que se desenvolvem sem influência exterior (Foto: Ivan Bolshakov/Unsplash)

Em inglês, há uma expressão que pode ser traduzida como “puxar-se pelas alças das próprias botas”, utilizada para situações difíceis que alguém precisa resolver sozinho sem ajuda externa. Essa expressão levou ao surgimento do termo bootstrap (literalmente “alça de bota”), usado em vários campos do conhecimento para se referir a processos que podem ser desenvolvidos dispensando a influência do exterior.

A filosofia por trás desse conceito também tem sido aplicada em alguns dos mais difíceis problemas que a Física enfrenta na atualidade, relacionados ao chamado acoplamento forte. Esse foi o tema de um workshop promovido pelo ICTP-SAIFR, centro internacional sediado no Instituto de Física Teórica (IFT) da Unesp, em junho e julho deste ano, com convidados e participantes de diversos países.

Nos sistemas fracamente acoplados, como gases ou a luz, as partículas não colidem ou interagem muito entre si e, portanto, estão mais livres. Estudá-los é relativamente simples, pois é possível usar um método conhecido como teoria de perturbações, que permite “quebrar” um problema em problemas menores. Isso porque é fácil separar as partes constituintes desses sistemas, ou seja, os “bloquinhos” dos quais são feitos.

Os sistemas fortemente acoplados, por sua vez, são muito mais difíceis de analisar. Nesses sistemas, muitas partículas interagem entre si ao mesmo tempo. Por causa disso, é como se suas partes constituintes formassem uma sopa, “mas tão misturada que você não consegue sequer separá-las. E nessa situação começa até a se tornar ambíguo o que é feito do quê”, aponta o físico russo Slava Rychkov, professor do Instituto de Estudos Científicos Avançados da França. Em casos assim, a teoria de perturbações não funciona e é preciso adotar outros modelos, como as teorias conformes. É aí que o bootstrap entra, ao oferecer uma nova abordagem para o estudo dessas teorias, baseada em princípios gerais.

Teorias conformes são especialmente úteis para descrever pontos críticos: por exemplo, transições de fase – quando água em estado líquido vira vapor ou quando um imã deixa de ser magnético. Uma das características desse tipo de fenômeno é a invariância de escala. Em outras palavras, não importa se você observa o sistema mais de perto ou mais de longe: ele parece se comportar da mesma forma.

O físico português Pedro Vieira, professor em conjunto do ICTP-SAIFR/IFT-Unesp e do Instituto Perimeter (Canadá), explica que investigações envolvendo teorias conformes são um desafio matemático: “muitas vezes, fazer as contas da forma tradicional é impensável porque são muitas variáveis”, com cálculos que exigem grande poder computacional. “A ideia do bootstrap é tentar chegar direto aos resultados sem passar pelas contas.”

Essa nova forma de pensar, que chega a ser contraintuitiva, coloca o pesquisador no papel de um navegador, analogia usada por Slava Rychkov. O “mar” seria um espaço de parâmetros, ou seja, todos os possíveis valores dentro de um modelo matemático específico. Ao resolver equações, segundo Rychkov, certas regiões surgem dentro desse “mar”, como se fossem ilhas, arquipélagos e continentes. Tais regiões podem conter teorias interessantes, a serem descobertas com o auxílio de técnicas analíticas e numéricas.

Pedro Vieira afirma que essa exploração de teorias, em busca de definir o que é possível e o que é impossível, leva os físicos a encontrar valores que, na sequência, é viável examinar de forma mais convencional: “quando já se sabe o resultado, é mais fácil voltar para os métodos tradicionais e tentar desenvolver novas armas para estudar esses modelos”. Outra forma de verificá-los, quando isso é exequível, é por meio de experimentos em aceleradores de partículas.

Colaboração internacional

Os mais recentes avanços no uso do bootstrap na Física têm sido promissores, estendendo-se para áreas variadas, que vão da teoria das cordas à matéria condensada, passando por holografia, buracos negros e até propostas para além do Modelo Padrão (o mais completo modelo até o momento para descrever a matéria visível). Por esse motivo, a Fundação Simons, uma tradicional financiadora internacional de ciência de ponta, mantém uma colaboração com dezenas de pesquisadores ao redor do mundo dedicados ao tema, incluindo Slava Rychkov e Pedro Vieira, além de pós-doutorandos e estudantes de doutorado.

De acordo com o físico português João Penedones, da Escola Politécnica Federal de Lausana (Suíça) e um dos pesquisadores principais da colaboração, a iniciativa ajudou a criar uma comunidade em torno do conceito, que se mantém ativa participando de reuniões periódicas e, uma vez por ano, se encontrando em uma grande conferência presencial, com duração de três a quatro semanas – a deste ano foi o workshop realizado pelo ICTP-SAIFR. “Dessa forma, nós continuamos colaborando juntos. Algumas pessoas exploram áreas ligeiramente diferentes, mas nós sempre nos reunimos para manter essa motivação e esse ímpeto”, diz Penedones.

Para Rychkov, que é diretor adjunto da colaboração, o financiamento oferecido pela Fundação Simons – aplicado em bolsas e serviços de tecnologia, necessários para rodar os algoritmos responsáveis pelos cálculos das pesquisas – é secundário diante do “efeito de amplificação” proporcionado pelos encontros regulares, que envolvem especialmente físicos em início de carreira: “Acho que isso foi maior do que seria se cada um de nós apenas recebesse esse dinheiro para fazer o que quiser sem questionamentos. Não seria possível fazer toda essa boa ciência que fizemos.”

Felipe Saldanha é jornalista de ciência do ICTP-SAIFR com bolsa da Fapesp.

Agradecimento: Francesco Aprile, da Universidade Complutense de Madri (Espanha)

Continue Reading | Comments Off on “Alça de bota”: um “truque” da Física para questões muito complexas

Professora do IFT-Unesp recebe prêmio internacional na área de Ciência das Redes Complexas

Hilda Cerdeira foi homenageada em conferência latino-americana

Por Felipe Saldanha

A docente tem desenvolvido pesquisas sobre sistemas dinâmicos não lineares e colaborado com cientistas de países em desenvolvimento (Foto: Divulgação/Universidade Andina de Cusco)

A professora Hilda Alicia Cerdeira, do Instituto de Física Teórica (IFT) da Unesp, recebeu um prêmio internacional em reconhecimento ao seu trabalho na área de Ciência das Redes Complexas e Sistemas Não Lineares. O LANET Award 2022 foi concedido à docente no dia 22 de agosto de 2023, durante a terceira edição da Conferência Latino-Americana de Redes Complexas (LANET), realizada em Cusco (Peru).

O diploma entregue à professora enfatiza “suas inestimáveis contribuições à Análise de Sistemas Dinâmicos Não Lineares e Redes por toda a região da América Latina”. Trata-se de um campo que descreve redes complexas e, como explica Hilda Cerdeira, possui inúmeros objetos de estudo, como redes elétricas, a internet, agrupamentos de seres vivos, movimentos de aviões e jogos de futebol. “Uma rede é um conjunto de nós e conexões e estas últimas não são necessariamente uma coisa física, mas podem ser simplesmente uma interação que você pode descrever matematicamente”, afirma.

A premiação também destacou “sua incansável dedicação em promover a educação e o empoderamento de jovens pesquisadores na área”. A docente conta que, já há algumas décadas, tem se dedicado a colaborar com físicos da América Latina, África e Ásia, promovendo aproximações entre eles. A atuação direcionada a cientistas de nações em desenvolvimento, inclusive, já havia garantido a ela o prêmio Espírito de Abdus Salam de 2021, concedido pelo Centro Internacional de Física Teórica (ICTP), na Itália. “Como eu tenho feito durante muito tempo esse tipo de trabalho, parece que tenho tocado muitas pessoas”, reconhece.

Argentina naturalizada brasileira, Hilda Cerdeira é doutora pela Universidade Brown (EUA), fez pós-doutorado na Alemanha e trabalhou na Universidade Estadual de Campinas e no ICTP da Itália, antes de se tornar professora do IFT. Ela integrou o comitê consultivo da revista Physics Today e é revisora de diversos periódicos da área. Também é sócia fundadora de uma startup, na qual aplica na área da saúde o resultado de suas pesquisas sobre redes.

Ao longo dos últimos anos, a docente co-organizou uma série de escolas sobre sistemas dinâmicos não lineares junto ao ICTP-SAIFR, centro internacional sediado no IFT-Unesp, que abordaram aspectos diversos como ótica e nanofotônica, redes complexas e neurociência, análise de séries temporais, complexidade socioeconômica, teoria da informação e aprendizado de máquina, além de uma escola iniciada em agosto sobre caos quântico.

Criada em 2017, a LANET tem o objetivo de proporcionar um fórum estável e periódico para reunir todos os cientistas que de alguma forma estejam relacionados com os estudos em Ciência das Redes na América Latina, estimulando a formação de grupos interessados na área e ajudando a estabelecê-la como uma disciplina nas universidades e instituições de pesquisa latino-americanas.

Felipe Saldanha é jornalista de ciência do ICTP-SAIFR com bolsa Fapesp.

Continue Reading | Comments Off on Professora do IFT-Unesp recebe prêmio internacional na área de Ciência das Redes Complexas

ICTP-SAIFR anuncia ganhadores de prêmio em Gravidade Clássica em 2023

Teses agraciadas abordam Princípio Copernicano, teorias alternativas de gravidade e detectores de ondas gravitacionais

Por Felipe Saldanha

David Camarena (no púlpito), autor da tese vencedora, recebeu certificado da premiação durante evento internacional em São Paulo (Foto: Thiago Codinhoto)

Foram anunciados os ganhadores da edição de 2023 do ICTP-SAIFR Prize in Classical Gravity and Applications, prêmio que reconhece pesquisas de teses de doutorado destacadas que promovem avanços na área de Gravidade Clássica e suas aplicações em Física de Ondas Gravitacionais, Astrofísica e Cosmologia.

O vencedor é David Camarena, doutor pelo Programa de Pós-Graduação em Astrofísica, Cosmologia e Gravitação (PPGCosmo) da Universidade Federal do Espírito Santo (Ufes) em 2022. Atualmente, ele é pesquisador de pós-doutorado na Universidade do Novo México (EUA). Sua tese propõe expandir as fronteiras da Cosmologia moderna para além do Princípio Copernicano, o qual presume que a Terra não ocupa lugar especial no universo. A pesquisa busca testar observacionalmente esse princípio e prever como futuros levantamentos astronômicos poderão detectar possíveis violações a ele.

O prêmio concedeu também menções honrosas. Guilherme Brando de Oliveira, doutor pelo PPGCosmo da Ufes em 2022 e pesquisador de pós-doutorado do Instituto Max Planck de Física Gravitacional (Alemanha), foi um dos agraciados. Em sua pesquisa doutoral, ele investigou teorias alternativas de gravidade para além do Modelo Padrão da Cosmologia, com o uso de ferramentas de matemática linear e não linear. Outro a receber menção honrosa foi Luís Felipe Longo Micchi, doutor pelo Programa de Pós-Graduação em Física da Universidade Federal do ABC em 2023 e assistente científico na Universidade Friedrich Schiller em Jena (Alemanha). Na tese, ele estuda dois tipos de fontes da terceira geração de detectores diretos de ondas gravitacionais, provenientes de buracos negros e estrelas de nêutrons.

O prêmio incluiu o convite para participar de um programa internacional sobre ondas gravitacionais que acontece neste mês de agosto em São Paulo, durante o qual as pesquisas premiadas foram apresentadas. Para David Camarena, o prêmio e a participação no evento impactaram de maneira abrangente o desenvolvimento de sua carreira e pesquisa. “No curto prazo, ampliou a visibilidade do meu trabalho, permitindo interações com destacados pesquisadores no campo da gravitação e suas aplicações, além de fortalecer as conexões com colaboradores de instituições brasileiras. No longo prazo, acredito que esse reconhecimento aumentará ainda mais o valor da minha pesquisa, abrindo portas para novas oportunidades nesta área”, destaca o pesquisador.

Na mesma linha, Luís Felipe Micchi acredita que a menção honrosa o ajuda a ganhar visibilidade internacional. “No mundo acadêmico, essa visibilidade é extremamente importante, uma vez que as colaborações em investigação são essenciais para a consolidação de uma carreira de sucesso. Em nível pessoal, acredito que esse prêmio ajuda (ex-)estudantes de pós-graduação, como eu, a ganhar autoconfiança no seu trabalho e a lidar com a síndrome do impostor que aflige muitos desses estudantes”, afirma.

Sobre o prêmio

O ICTP-SAIFR Prize in Classical Gravity and Applications recebe nomeações de teses doutorais de qualquer país da América Latina, normalmente feitas pelo orientador do trabalho. Os candidatos precisam ter defendido não mais de 18 meses antes do prazo de indicação. Cada autor pode ser nomeado apenas uma vez, mas os candidatos que não forem aprovados serão reconsiderados no ano seguinte.

Os nomeados são avaliados por um comitê internacional, que neste ano incluiu Vitor Cardoso, da Universidade de Lisboa (Portugal); Rodrigo Fernandez, da Universidade de Alberta (Canadá); Walter Goldberger, da Universidade Yale (EUA); Gabriela Gonzalez, da Universidade do Estado da Louisiana (EUA); e Luis Lehner, do Instituto Perimeter (Canadá).

O vencedor recebe R$ 1.000 e, junto aos agraciados com menção honrosa, certificado e convite para palestrar em um evento anual do ICTP-SAIFR, com todas as despesas pagas. Os vencedores das edições anteriores e mais informações sobre o prêmio estão disponíveis no site ictp-saifr.org/gravityprize. A previsão é que as inscrições para a próxima edição sejam abertas no início de 2024, com prazo para submissão até 30 de abril.

Felipe Saldanha é jornalista de ciência do ICTP-SAIFR com bolsa Fapesp.

Continue Reading | Comments Off on ICTP-SAIFR anuncia ganhadores de prêmio em Gravidade Clássica em 2023

A tecnologia quântica de segunda geração vai chegar ao Brasil?

Reportagem por Ana Clara Moreira

No dia 30 de janeiro, teve início o evento internacional “Tecnologias Quânticas para São Paulo, Brasil e América Latina”, realizado pelo Instituto Principia e o ICTP-SAIFR. Com encerramento no dia 16 de fevereiro, o workshop reunirá membros da academia e da indústria para debater o estado da arte do desenvolvimento de tecnologias quânticas na região, além de delimitar metas e estratégias para estimular o avanço na área. O encontro acontecerá presencialmente em São Paulo e surgiu da necessidade de estreitar a relação entre a pesquisa e a indústria, visando o aprimoramento das tecnologias quânticas no Brasil, tornando-o uma potência no campo.

Marcelo Terra Cunha é professor da Unicamp e um dos organizadores do evento, e explica que o olhar da física quântica vem mudando com o tempo: “Muito tempo se passou desde que ela se preocupava com os átomos e com a compreensão das propriedades da matéria. Uma consequência indireta e não planejada nos estudos de física quântica foi a descoberta da teoria quântica. Ela possibilita descrever experimentos e calcular as probabilidades de cada possível resposta para cada medição, além de apresentar “características informacionais”. Nesse sentido, uma das descobertas informacionais foi a teleportação quântica, que permite o transporte de informação.

Hoje, as tecnologias quânticas estão em sua segunda geração. Aquelas conhecidas como sendo de “primeira geração” são tecnologias que estão no dia-a-dia, como os semicondutores minúsculos que compõem os chips de computadores e celulares ou os lasers em aparelhos de cd e dvd, que lêem os arquivos de áudio e vídeo. “As tecnologias quânticas de primeira geração estão no nosso cotidiano e são parte essencial do PIB mundial, é graças a elas que conseguimos viver nessa era de informação quase instantânea”, explica Terra Cunha. “Essas tecnologias usam o primeiro ponto da teoria quântica, referente a parte da descrição atômica dos fenômenos, relacionado aos níveis discretos”, completa.

Já as tecnologias quânticas de segunda geração são representadas pela computação quântica, pela comunicação quântica e por sensores quânticos. Elas exploram outras características da teoria quântica, como a coerência quântica. Esse fenômeno lida com a ideia de que todos os objetos têm propriedades semelhantes a ondas. Se o estado ondulatório de um objeto for dividido em dois, então as duas ondas podem interferir uma na outra de maneira coerente, de modo a formar um novo estado único, a partir da superposição desses dois estados. Ou seja, na superposição, um único estado quântico consiste em múltiplos estados, equivalente a um bolo de camadas: o bolo final existe graças à combinação de camadas diferentes de bolo.

Ao ser questionado sobre o papel do Brasil no desenvolvimento das tecnologias quânticas, Terra Cunha afirma com certeza que o país não fica para trás no quesito de investimento na área. O professor relembra que, no fim dos anos 90, foi criado o Instituto do Milênio de Informação Quântica e logo depois o Instituto Nacional de Ciência e Tecnologia Quântica. Em termos de comunidade, o Brasil também está bem posicionado pois existe uma comunidade grande de físicos trabalhando no campo.

Entretanto, para que os avanços sigam ocorrendo, é preciso investir em propostas de curto e longo prazo que consistem, principalmente, na formação de engenheiros quânticos. Terra Cunha conta como, no Brasil, ainda faltam profissionais com formação em engenharia trabalhando em campos de tecnologia quântica e permitindo a interação entre pesquisa teórica e aplicações práticas.

Para lidar com essa problemática, o pesquisador defende a ideia de cooperações internacionais, especialmente no continente latino-americano. “Na Argentina, por exemplo, existem grandes líderes mundiais em tecnologias quânticas, como o Juan Pablo Paz que é Secretário de Articulação Científica e Tecnológica do Ministério de Ciência, Tecnologia e Inovação da Argentina. Paz, inclusive, convidou o Brasil para participar do programa argentino. Além disso, o Chile também tem uma grande experiência em óptica quântica, então uma união entre as universidades e empresas latino-americanas faz todo mundo ganhar”, afirma. O professor também explica que, no futuro, o Brasil se tornará um consumidor de tecnologias quânticas e, por conta disso, seria interessante que o país também se tornasse criador e exportador dessas tecnologias, integrando e criando um ecossistema mundial de cooperação.

Tendo isso em mente, Terra Cunha, juntamente com pesquisadores de outras regiões do Brasil, dos Estados Unidos e da Holanda organizaram o encontro que terá início nesta semana, objetivando desenvolver um plano para colocar em prática ações para posicionar o Brasil em um cenário de destaque no campo de tecnologias quânticas nos próximos anos. “Para isso, nas duas primeiras semanas do evento, os participantes debaterão um tema específico a cada dia, que posteriormente irão compor capítulos do documento oficial do planejamento”, explica Terra Cunha.

Entre os temas que serão debatidos, estão as perspectivas de aplicações de tecnologias quânticas para a agricultura e saúde, ponto que é visto com entusiasmo pelo pesquisador, uma vez que o Brasil é um dos maiores exportadores de commodities agrícolas do mundo. “Seria ótimo que esse tipo de tecnologia pudesse ser desenvolvida aqui, pois naturalmente vamos usar e precisar dela”, comenta Terra Cunha. Na agricultura, algumas das tecnologias quânticas usadas são os sensores quânticos: equipamentos que utilizam propriedades quânticas que possibilitam maior sensibilidade e com menor dano. Por isso, uma das apostas do evento é nos sensores, pois acredita-se que eles têm o potencial de apresentar o melhor ganho por real investido, além de poderem ser aplicados também na área da saúde, tanto animal quanto vegetal.

Um exemplo de sensor quântico é o gravímetro. Essa tecnologia é desenvolvida a partir do conceito de sobreposição atômica, para medir o nível de variação gravitacional da Terra. Ela pode ser utilizada, por exemplo, para identificar quais tipos de solos e sedimentos existem em um determinado lugar, sem ser necessário escavar a região. Essa utilização permite, também, encontrar objetos enterrados ou submersos a um certo nível de profundidade.

Apesar do impacto positivo para a indústria agrícola, Terra Cunha defende que o Brasil tem capacidade para ir além. “O Brasil tem condições de dar esse salto e ser bom em produzir tecnologias e avanços científicos, ele não precisa continuar sendo um país agrícola para sempre. Aqui, nós temos a vantagem de não estarmos começando do zero. Outros países, como Singapura e os Emirados Árabes, que começaram do zero já estão desenvolvendo esse tipo de tecnologia”, finaliza.

Continue Reading | Comments Off on A tecnologia quântica de segunda geração vai chegar ao Brasil?

Formação em Biologia e Ecologia Quantitativas realizada por ICTP-SAIFR e Instituto Serrapilheira começa em julho

Reportagem por Yama Chiodi e Malena Stariolo

Na próxima segunda, dia 4 de julho, começa a segunda edição do Programa de Formação em Biologia e Ecologia Quantitativas. Após uma primeira edição online, realizada em 2021, em 2022 o curso será presencial e contará com a participação de pesquisadores de ponta, que ministrarão minicursos para os 31 estudantes selecionados de diversas áreas e vindos de várias partes do Brasil e da América Latina. O programa surgiu a partir de uma parceria entre o Instituto Serrapilheira e o ICTP-SAIFR, visando cobrir uma demanda pela criação de uma comunidade de cientistas capazes de aplicar métodos matemáticos e computacionais à biologia e à ecologia no Brasil.

Ricardo Martínez-García, pesquisador do ICTP-SAIFR e coordenador científico das duas primeiras edições do programa, conta que o ICTP-SAIFR surgiu como um ótimo instituto parceiro, por sua tradição e objetivo de impulsionar a pesquisa em física teórica na América Latina e por realizar, desde 2012, a escola de verão de Biologia Matemática, organizada pelo pesquisador Roberto Kraenkel. “Pra mim foi como colocar juntos esses dois interesses, do ICTP-SAIFR de criar oportunidades para jovens cientistas latino-americanos, e do Serrapilheira de ter esse foco muito claro no treinamento de cientistas para estudar sistemas biológicos complexos”, afirma ele.

Durante os cinco meses de duração do programa, os participantes terão aulas com pesquisadores de ponta das áreas de biologia e ecologia quantitativas, além de terem a oportunidade de conviver uns com os outros, em um ambiente estimulante para trocas de ideias e experiências. Segundo a pesquisadora Flávia Marquitti (Unicamp), que participa da coordenação científica deste ano e liderará a terceira edição prevista para 2023, a presença de colegas e professores de origens, universidades e grupos de pesquisa diversos vai expor os alunos a diferentes formas do fazer científico e enriquecer eventuais trabalhos feitos após o treinamento oferecido pela formação.

A interdisciplinaridade é uma das grandes características do programa, nesse contexto Marquitti avalia que há poucos espaços interdisciplinares na pós-graduação no Brasil, o que acaba criando um vácuo na formação de cientistas capazes de solucionar problemas que só poderão ser resolvidos no trabalho conjunto entre biologia, matemática e outras áreas. Para ela, as disciplinas têm suas próprias abordagens e enxergam possibilidades distintas para problemas em comum. A pesquisadora comenta: “quando diferentes disciplinas trabalham juntas elas não são só uma soma. Falando especificamente da aplicação, de usar modelos matemáticos nas áreas biológicas, a gente ganha muita informação e consegue generalizar algumas coisas que só com o conhecimento das biológicas a gente não conseguiria”.

O caminho contrário também é verdadeiro. Se a matemática pode ajudar as ciências biológicas a construir formalismos e generalizações, os cientistas das exatas vão aprender que a biologia impõe importantes limites no que pode ser generalizável. A professora acrescenta que “não dá pra fazer uma teoria de tudo na biologia. Então, quando a gente une as duas áreas, as exatas aprendem a conhecer os limites biológicos, para só então conseguir modelos que sejam aplicáveis pras ciências da vida”.

Ambos os coordenadores científicos compartilham da opinião de que os espaços para formação e pesquisa interdisciplinar ainda são incipientes no Brasil e que, geralmente, aparecem muito tarde na carreira do pesquisador. Martínez-García diz que, no programa, os alunos vão ser treinados para problemas que não podem ser resolvidos por uma pessoa ou mesmo por um grupo de pessoas da mesma área de formação, segundo ele: “problemas como a perda de diversidade e as mudanças climáticas não vão ser resolvidos por pessoas de só uma expertise. Vão ser necessárias equipes transdisciplinares e eles vão ter que aprender a falar uns com os outros. Físicos e ecólogos normalmente não falam a mesma língua, por exemplo”. É por essa razão que Marquitti considera que o programa é de fato um treinamento, diferente de cursos acadêmicos tradicionais.

A expectativa é que, ao fim do programa, os alunos consigam trabalhar juntos em áreas interdisciplinares, além disso, outro objetivo é formar uma rede de pesquisadores que contribuirá para o avanço da ciência. Para isso, Martínez-García comenta que estão previstos encontros anuais entre os ex-alunos do programa, que poderão estreitar laços profissionais e de pesquisa. Entre 4 de julho até 2 de dezembro serão realizados minicursos, seminários de pesquisa, sessões de debate, journal clubs e outras atividades que os selecionados do programa poderão participar. Para conhecer em detalhe todas as atividades, palestrantes, temas e participantes, basta acessar o site do programa no endereço https://www.ictp-saifr.org/qbioprogram/.

Criado em 2017, o Instituto Serrapilheira é a primeira instituição privada de apoio à ciência e à divulgação científica no Brasil. Sem fins lucrativos e com recursos oriundos de um fundo patrimonial, já apoiou 150 projetos de pesquisa e 58 de divulgação científica.

O ICTP-SAIFR é um centro de pesquisa em Física Teórica, vinculado ao IFT-UNESP e ao Abdus Salam International Centre for Theoretical Physics em Trieste, com apoio financeiro da FAPESP, UNESP e Instituto Serrapilheira. O ICTP-SAIFR realiza diversas atividades de treinamento para pesquisadores, como workshops e escolas, o cronograma pode ser acessado no site do instituto: http://ictp-saifr.org. Além disso, o SAIFR também organiza atividades de divulgação e extensão para professores e estudantes de Ensino Médio e para o público geral, confira a programação em: http://outreach.ictp-saifr.org.

Continue Reading | Comments Off on Formação em Biologia e Ecologia Quantitativas realizada por ICTP-SAIFR e Instituto Serrapilheira começa em julho

Pesquisa sobre competição subterrânea entre plantas na revista Science

Abaixo da superfície, plantas travam uma constante disputa pelo espaço e recursos presentes no solo. Embora ocorra escondida do olhar humano, o entendimento da complexa dinâmica de raízes no subsolo pode trazer consequências muito significativas para a sociedade, abrangendo desde a criação de plantios mais sustentáveis e eficientes, até o estabelecimento de estratégias de mitigação de efeitos climáticos. No estudo The exploitative segregation of plant roots, publicado em 4 de dezembro na revista Science, é apresentado um modelo matemático capaz de mapear as interações entre raízes de plantas que acontecem embaixo da terra, dando uma nova luz ao entendimento de um mecanismo ecológico fundamental. O trabalho foi desenvolvido por um grupo de pesquisadores de instituições do Brasil, Espanha e Estados Unidos, e contou com a participação de Ricardo Martínez-García, professor SIMONS-FAPESP no Instituto Sul-Americano para Pesquisa Fundamental (ICTP-SAIFR) e no Instituto de Física Teórica da UNESP (IFT-UNESP), como um dos principais autores da pesquisa.

Raízes tingidas de plantas de pimenta. O tingimento é empregado como método de diferenciação entre raízes de plantas vizinhas para facilitar o estudo de sua interação. Imagem cedida por Ciro Cabal.

Em entrevista concedida por videoconferência ao ICTP-SAIFR, o professor Martínez-García fala sobre algumas das motivações do trabalho: “Muito da dinâmica dos ecossistemas na verdade acontece abaixo da terra. Se nós pretendemos entender como os ecossistemas funcionam, e como, por exemplo, respondem a mudanças globais, nós precisamos compreender o que acontece no subsolo. Não basta apenas entender a parte que conseguimos observar.” Martínez-García dedica sua pesquisa à área da Física aplicada à Biologia, em especial ao desenvolvimento de modelos físico-matemáticos para estudar sistemas ecológicos complexos, e foi um dos responsáveis pelo desenvolvimento teórico neste estudo.

O modelo apresentado neste trabalho simula o balanço entre a quantidade de energia gasta por uma planta para produzir uma certa quantidade de raiz em uma dada direção, em relação ao ganho de recursos – nesse caso, absorção de água – que a planta terá ao produzi-la. O professor exemplifica: “Em cada ponto do espaço, uma planta somente vai colocar raízes se o recurso nesse ponto é suficientemente alto para devolver um benefício para ela. (…) Para uma planta absorver recursos a 2 m do seu caule, é mais custoso do que a 10 cm, pois como ela não pode se deslocar, precisa fazer uma raiz mais longa. Construir todo esse mecanismo mais longo é energeticamente mais custoso para ela. Então esse é o balanço.” A presença de uma segunda planta na vizinhança muda a dinâmica dessa balanço, pois nesse cenário os dois organismos passam a competir pela água disponível no solo ao redor. Dessa maneira a distribuição de raízes no solo ganha um grau de complexidade maior. “Imagine que você tem uma certa quantidade de água em um ponto do espaço. Esse ponto fica a 2 m de uma planta e a 0,5 m de outra. Mesmo que as duas dividissem essa quantia de água de maneira idêntica, para uma planta o custo seria menor do que para a outra. O benefício da planta que está mais perto é maior, por isso as plantas se espalham menos quando têm vizinhas.”

Embora essa relação seja simples o bastante de compreender, o caminho para se chegar a um modelo matemático capaz de simular precisamente a proporção em que esse balanço ocorre exige uma base matemática muito forte. De fato, uma das coisas mais interessantes sobre o modelo, explica o professor, é o fato de ele ter sido inspirado por uma aparente contradição existente em modelos predecessores. “Dentre os grupos de pesquisa que já buscaram entender esse processo, de como plantas mudam seu sistema de raízes na presença de outras plantas, tinha duas maneiras de responder essa pergunta: havia grupos de pesquisadores que não consideravam a distribuição no espaço, medindo apenas a massa total de raiz produzida. Desses estudos concluiu-se que se uma planta tem uma vizinha próxima, ela irá gerar mais raiz: a resposta de uma planta a uma competição por recursos seria ter mais raízes, para tentar absorver mais, e mais rápido.”

“Outro grupo apenas mediu quanto espaço a planta cobre com suas raízes. No lugar de se perguntar quanta massa de raiz as plantas geram, perguntou-se de que maneira o território do qual a planta absorve água muda na presença de uma vizinha. A conclusão foi que neste caso as plantas ocupam um território menor, espalhando-se menos. Aí ficou uma contradição, pois se há um espalhamento menor, como você produz mais raiz?”, aponta o professor. Uma maior densidade de raízes, explica, poderia responder essa aparente contradição, mas os modelos até então não possuíam informação suficiente para afirmar que este seria o caso. “Então o que nós fizemos foi um modelo geral que introduz o espalhamento das plantas junto com a quantidade de raiz em cada local do espaço. Leva em consideração as duas coisas. E com a técnica experimental que usamos, conseguimos fazer uma reconstrução espacial completa. (…) A conclusão geral na qual chegamos foi justamente que: sim, as plantas se espalham menos na presença de uma vizinha, sendo mais locais na procura de recursos, mas nas suas proximidades elas se tornam mais agressivas, isto é, produzem mais raízes perto do próprio caule.”

Ricardo Martínez-García é professor SIMONS-FAPESP no ICTP-SAIFR e no IFT-UNESP. Sua pesquisa busca empregar técnicas computacionais e de Física Estatística para examinar a formação de padrões de organização em sistemas biológicos complexos, e abrange desde estudos com micróbios até plantas e paisagens inteiras. Imagem cedida por Ricardo Martínez-García.

As predições do modelo foram testadas em um experimento conduzido no Instituto de Ciências Agrárias de Madri, na Espanha. O teste foi feito em uma variedade de espécies de plantas de pimenta, cultivadas em estufa por 11 meses sob condições muito controladas para esse experimento. “É comum na Biologia você fazer um experimento com uma espécie modelo. (…) Nós usamos a planta de pimenta pois o Ciro Cabal, que é o autor principal do artigo, já conhecia o organismo para cultivá-lo de uma maneira mais controlada. Uma vez que você descobre um mecanismo num organismo modelo, aí vem a questão de como generalizar para outras espécies, do quão geral o modelo é etc.” É a mesma lógica, comenta o professor, do uso de ratos de laboratório em estudos sobre doenças humanas. Após o crescimento das plantas, caules e folhas foram cortados e colhidos. As raízes, ainda no solo, foram tingidas com pigmentos de cores diferentes, a fim de permitir o reconhecimento de cada planta em meio ao emaranhado de raízes. “Depois de colorir as plantas, fizemos diversas pequenas divisões no solo, e então pudemos ver o quanto cada planta possuía de raiz em cada divisão. Com isso, conseguimos construir um mapa espacial das raízes de cada planta.”

“Quando o Ciro Cabal escreveu para mim com os resultados dos experimentos realizados, e a figura do experimento era a mesma que uma das figuras do nosso modelo, para mim essa foi a maior satisfação. Não apenas de um ponto de vista pessoal, mas por se tratar de um mecanismo fundamental da Ecologia que ainda não era conhecido.”, relata o professor. Para além da contribuição para a ciência de base, a existência de um modelo matemático como esse, capaz de descrever a competição entre plantas que se passa no subsolo, pode trazer implicações muito expressivas para a maneira como é feita agricultura, permitindo a criação de um sistema de plantio otimizado e o aumento da produção de alimentos. “Se eu colocar 15 cm entre as minhas plantas, elas irão investir menos em produção de raízes e mais em produção de frutas, por exemplo. Isso pode aumentar muito a eficiência de cultivos com um investimento de água menor.”, conjectura o professor. Além disso, as raízes constituem uma grande reserva de carbono, que armazena aproximadamente um terço de toda a biomassa de plantas do planeta. Por isso, uma melhor compreensão do seu comportamento permitirá o desenvolvimento de melhores modelos de grande escala, com os quais cenários de mudanças climáticas podem ser simulados.

Desse ponto em diante, o trabalho de Martínez-García e seus colaboradores deve seguir rumo ao aprofundamento do modelo: estudar as interações envolvendo sistemas com mais de duas plantas, espécies diferentes e em condições climáticas distintas — esses são alguns dos próximos passos na lista dos pesquisadores. “O que fizemos foi uma primeira contribuição, dar uma ideia dos mecanismos que dominam esses padrões espaciais de raízes. Evidentemente há muito mais trabalho para fazer, mas encaixar a primeira peça é uma grande satisfação.”, conclui o professor.

——————————————————————————————————————————-

O artigo The exploitative segregation of plant roots, publicado em 4 de dezembro de 2020 na revista Science, é de autoria de Ciro Cabal (Universidade de Princeton, Estados Unidos), Ricardo Martínez-García (ICTP-SAIFR/IFT-UNESP, Brasil), Aurora de Castro (Museu Nacional de Ciências Naturais, Espanha), Fernando Valladares (Museu Nacional de Ciências Naturais/Universidade Rei Juan Carlos, Espanha) e Stephen W. Pacala (Universidade de Princeton, Estados Unidos).

Continue Reading | Comments Off on Pesquisa sobre competição subterrânea entre plantas na revista Science